ปกติแล้ว Apple เป็นแบรนด์ที่ใส่ใจในด้านความเป็นส่วนตัวของผู้ใช้งานมาก ๆ แบรนด์นึง เพราะแทบจะไม่มีการเข้ามายุ่งวุ่นสายกับข้อมูลอะไรของลูกค้าเลย…แต่หลังจากนี้ Apple อาจต้องขอยกเว้นนโยบายความเป็นส่วนตัวบางข้อของลูกค้าเพื่อแลกกับสิ่งที่ดีกว่า เพราะกำลังจะมีการอัปเดตอุปกรณ์ iOS และ iPadOS เพื่อใส่ซอฟท์แวร์ที่ใช้ในการสแกนรูปภาพหรือวิดีโอที่เก็บไว้บน iCloud ว่ามีสื่อลามกที่เกี่ยวข้องกับการล่วงละเมิดทางเพศเด็กอยู่ด้วยหรือไม่

ระบบตรวจจับภาพเกี่ยวกับการละเมิดทางเพศเด็ก

Apple ออกมาประกาศบนหน้าเว็บไซต์ของตัวเองอย่างเป็นทางการแล้วว่าจะใช้เทคโนโลยีในการตรวจจับสื่อลามกที่เป็นการล่วงละเมิดทางเพศเด็กสำหรับอุปกรณ์ iOS และ iPadOS โดยเป็นซอฟท์แวร์ที่จะสามารถสแกนและตรวจจับ CSAM หรือ Child Sexual Abuse Material (วัตถุหรือสิ่งแสดงการล่วงละเมิดทางเพศเด็ก) ที่อยู่ในอุปกรณ์อย่าง iPhone หรือ iPad ซึ่งการสแกนดังกล่าวจะสแกนไฟล์ Media ในอุปกรณ์ iOS / iPadOS ที่กำลังจะอัปโหลดไปใส่ iCloud เท่านั้น ไม่ได้ไปไล่สแกนไฟล์ทั้งหมดในระบบ iCloud นะครับ

เมื่อซอฟท์แวร์ดังกล่าวสแกนเจอรูปภาพหรือวิดีโอที่น่าจะเกี่ยวข้องหรือเป็น CSAM แล้ว จะมีการแจ้งเตือนไปทาง Apple เพื่อถอดรหัสไฟล์ให้พนักงานที่เป็นมนุษย์จริง ๆ ตรวจสอบอีกรอบว่ามันเป็นสื่อเกี่ยวกับการละเมิดทางเพศเด็กซึ่งผิดกฎหมายจริงรึเปล่า และหากพบว่าเข้าข่ายก็จะแจ้งเตือนไปยังทางการเพื่อเข้ามาตรวจสอบอีกที โดย Apple เคลมว่าเทคโนโลยีตรวจจับ CSAM มีความแม่นยำสูงมาก อาจเกิดความผิดพลาดในการตรวจจับน้อยสุด ๆ แค่หนึ่งในล้านล้านครั้งต่อปีเท่านั้น

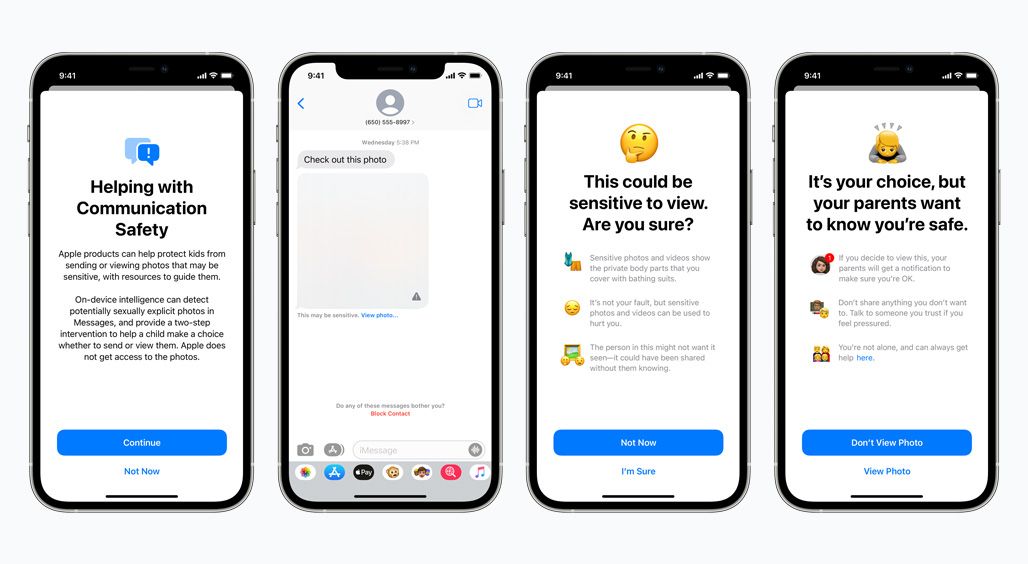

แอป Messages เพิ่มฟีเจอร์ตรวจจับภาพไม่เหมาะสมที่ถูกส่งมา

และไม่ใช่แค่การจะตรวจจับ CSAM เท่านั้น แต่แอปแชท Messages ยังจะใส่ระบบตรวจจับสื่อที่ไม่เหมาะสมกับอายุของผู้ใช้งาน iPhone กับ iPad ด้วย เมื่อระบบตรวจพบว่ามีการส่งภาพโป๊อนาจารเข้ามาที่อุปกรณ์ของผู้ใช้ที่ยังเป็นเยาวชนอยู่ ภาพจะถูกเบลอไว้ก่อน และจะมีแจ้งเตือนเด้งขึ้นมาถามว่าต้องการดูภาพนี้จริง ๆ รึเปล่า ซึ่งหากว่าผู้ใช้ยังยืนยันจะขอดู ก็จะมีการแจ้งเตือนไปยังอุปกรณ์ของผู้ปกครองด้วย ว่าลูกกำลังจะดูภาพที่ไม่เหมาะสม

Siri และ Search เพิ่มฟีเจอร์แนะนำถึงความไม่ถูกต้องของ CSAM

นอกจากนี้ Apple ยังจะอัปเดตเพื่อจำกัดการค้นหาข้อมูลเกี่ยวกับ CSAM จาก Siri และ Seach ด้วยการแจ้งเตือนผู้ใช้งานที่ต้องการหาข้อมูลเหล่านั้นว่ามันเป็นเรื่องที่ไม่ถูกต้องพร้อมกับแนะนำวิธีแก้ปัญหาต่อไป และสำหรับผู้ที่ต้องการรายงานข้อมูลเกี่ยวกับการละเมิดทางเพศเด็กก็สามารถถาม Siri เพื่อขอวิธีแจ้งความได้เลย

ฟีเจอร์สำหรับการตรวจจับและป้องกันการล่วงละเมิดทางเพศเด็กเหล่านี้ จะเริ่มปล่อยอัปเดตให้กับอุปกรณ์ที่ใช้ iOS 15, iPadOS 15, WatchOS 8 และ macOS Monterey ในช่วงปลายปีนี้ครับ

ที่มา : AndroidAuthority, Apple

ผมว่า แบบนี้ก็จะหลายเป็นเรื่องไม่ส่วนตัวทุกเรื่องต่อไปครับ

ถือว่าเป็นการละเมิดสิทธิส่วนบุคคลด้วยไหมเนี่ย

* Features available in the U.S. ทำไมไม่แปลด้วยครับ ในที่มา ที่ * ทุกฟีเจอร์ มีเขียนไว้ใต้ล่างสุด ทำไมไม่แปลครับ

หรือเพราะเป็นเว็บที่อริกับยี่ห้อนี้อยู่แล้วถึงไม่แปลส่วนนี้กันครับ?

ถ้าแปล คุณจะเข้ามาดูเหรอครับ ^^"

เว็บนี้ไปเป็นอริกับ Apple ตอนไหนเหรอครับ???

ผมว่าเว็ปนี้ลงข่าว Apple เร็วและละเอียดมากๆเลยในไทย ไปดูเว็ปที่เน้น Apple ซิ ข่าวไม่ค่อยมีหรอก มีแต่ขายของ ไม่อยากเอ่ยชื่อ คือจะขายของก็ไม่แปลกหรอกเพราะหาเงิน หาผู้สนับสนุน แต่ข่าวน้อยเกินที่จะเสพ

สงสัยผมใช้คำหนักไปหน่อย ขอโทษที

เอาเป็นว่าแก้ไขแล้วก็ตามดูตามปกติ ติดตามเว็บประจำอยู่แล้ว แค่ไม่ค่อยได้คอมเมนต์

แก้ไขยังไงเหรอครับ ผมไม่เห็นว่ามีการเพิ่มข้อความ "ฟีเจอร์นี้เฉพาะ us" ลงไปในบทความเลยนะครับ

แต่เอาจริงๆ ใจร่มๆ คุยกันดีๆ ก็ได้ครับ บทความต้นทางของ android authority ไม่ระบุ แต่ทาง apple ระบุ บางทีคนเรียบเรียงอาจจะไม่ได้เข้าไปดูจาก apple ก็เป็นไปได้ครับ ปรับคำพูดหน่อยเป็น "ผมเห็นในเว็บ apple ระบุว่า Features available in the U.S ใส่เพิ่มในบทความก็ดีนะครับ คนจะได้ไม่ตกใจกัน"

กำลังคิดว่าเค้าตรวจยังไงว่าในวิดีโอนั้นคือเด็ก ดูจากอะไร หน้าตาหรืออวัยวะที่แสดงความเป็นเด็ก? แล้วถ้าไม่เห็นหน้าล่ะ หรือถ้าบางคนแว็กซ์ล่ะ ยิ่งแอปเปิ้ลบอกแม่นยำมาก ถ้าขนาดนั้นได้แปลว่า AI ต้องเจ๋งสุดๆ เลยนะ ถ้าพัฒนาให้ถูกทาง สามารถใช้หาบุคคลในสื่อได้เลย แบบในหนังอะ