จากที่มีข่าวออกมาตั้งแต่ต้นเดือนสิงหาคมว่าทาง Apple จะใส่ซอฟท์แวร์สำหรับตรวจจับ CSAM หรือ Child Sexual Abuse Material (วัตถุหรือสิ่งแสดงการล่วงละเมิดทางเพศเด็ก) ที่อยู่ในอุปกรณ์อย่าง iPhone หรือ iPad โดยนึกถึงความปลอดภัยของเยาวชนเป็นหลัก และเมื่อมีข่าวนี้ออกมาปุ๊บ ก็แน่นอนว่าต้องมีเสียงวิพากษ์วิจารณ์เกี่ยวกับความเป็นส่วนตัวของผู้ใช้งานกันให้พรึ่บ จนล่าสุดทาง Apple ก็เลยต้องขอเบรกนโยบายดังกล่าวเพื่อพิจารณาเพิ่มเติมอีกครั้งนึง

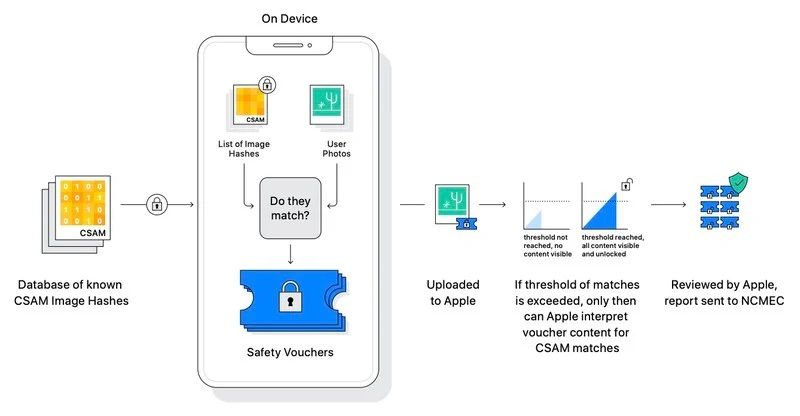

ในตอนแรก Apple จะใส่ระบบตรวจจับ CSAM ผ่านการอัปเดต iOS 15, iPadOS 15, WatchOS 8 และ macOS Monterey ในช่วงปลายปีนี้ ซึ่งระบบดังกล่าวจะตรวจจับสื่อลามกที่เป็นการล่วงละเมิดทางเพศเด็กสำหรับอุปกรณ์ iOS และ iPadOS โดยใช้ซอฟท์แวร์ที่จะสามารถสแกนและตรวจจับ CSAM หรือ Child Sexual Abuse Material (วัตถุหรือสิ่งแสดงการล่วงละเมิดทางเพศเด็ก) ที่อยู่ในอุปกรณ์อย่าง iPhone หรือ iPad ซึ่งการสแกนดังกล่าวจะสแกนไฟล์ Media ในอุปกรณ์ iOS / iPadOS ที่กำลังจะอัปโหลดไปใส่ iCloud เท่านั้น

ทำให้เกิดการวิพากษ์วิจารณ์ขึ้นมามากมายทั้งจากผู้ใช้งานทั่วไป, กลุ่มผู้สนับสนุนแบรนด์, กลุ่มนักวิจัย และอื่น ๆ ว่ามันจะเป็นการละเมิดความเป็นส่วนตัวของผู้ใช้ เพราะถึงแม้ Apple อ้างว่าว่าระบบจะสแกนเฉพาะไฟล์ Media (ภาพ / วิดีโอ) ที่อาจเข้าข่าย CSAM ซึ่งถูกอัปโหลดไปบน iCloud เท่านั้น และจะไม่ไปยุ่งวุ่นวายกับไฟล์ในตัวอุปกรณ์เลย

แต่เหล่านักวิจัยความปลอดภัยและความเป็นส่วนตัวก็ยังอดเป็นห่วงไม่ได้ว่า ระบบดังกล่าวอาจถูกหน่วยงานระดับสูงของรัฐบาลสหรัฐเข้าแทรกแซงเพื่อใช้ในการตรวจหาไฟล์อื่น ๆ นอกเหนือไปจาก CSAM ด้วย นอกจากนี้แอป Photos บน iPhone และ iPad ยังมีการตั้งค่า Default ให้อัปโหลดไฟล์ขึ้น iCloud โดยอัตโนมัติ ทำให้ผู้ใช้งานที่ไม่รู้เรื่องนี้และไม่ได้ปิดการ Back up เอาไว้ เท่ากับว่าโดนสแกนรูปภาพ และวิดีโอทั้งหมดไปโดยปริยาย

ตอนนี้ Apple ก็เลยต้องขอเบรกการใส่ระบบตรวจจับ CSAM เอาไว้ก่อน โดยแจ้งว่าทางบริษัทขอใช้เวลาในการเก็บข้อมูลเพิ่มเติม และพัฒนาระบบให้ดีขึ้นกว่านี้ ก่อนที่จะปล่อยระบบดังกล่าวออกมาในอนาคต ซึ่งยังไม่มีการระบุช่วงเวลาเอาไว้แต่อย่างใดครับ

ที่มา : Techcrunch

Comment