กูเกิลเพิ่มการรองรับการถ่ายและการแสดงภาพ Ultra HDR เข้ามาเป็นครั้งแรกบน Android 14 ช่วยให้ภาพถ่ายดูมีมิติแสงเงาสมจริงกว่า HDR แบบเดิม ๆ (ซึ่งไม่ใช่ HDR ที่แท้จริง แต่เรียกให้เข้าใจง่าย) ทว่า ปัญหาที่เกิดขึ้นจนถึงก่อนหน้านี้คือ ยังมีซอฟต์แวร์เพียงไม่กี่ตัวในตลาด ที่รองรับการแก้ไขและตกแต่งภาพ Ultra HDR หรือบางแอปอาจรองรับ แต่ให้ผลลัพธ์ที่เพี้ยน ไม่เว้นแม้กระทั่ง Google Photos เองที่รวมอยู่ในกลุ่มหลัง ล่าสุดกูเกิลจึงไปทำการบ้านมาใหม่ เพื่อแก้ปัญหาดังกล่าว

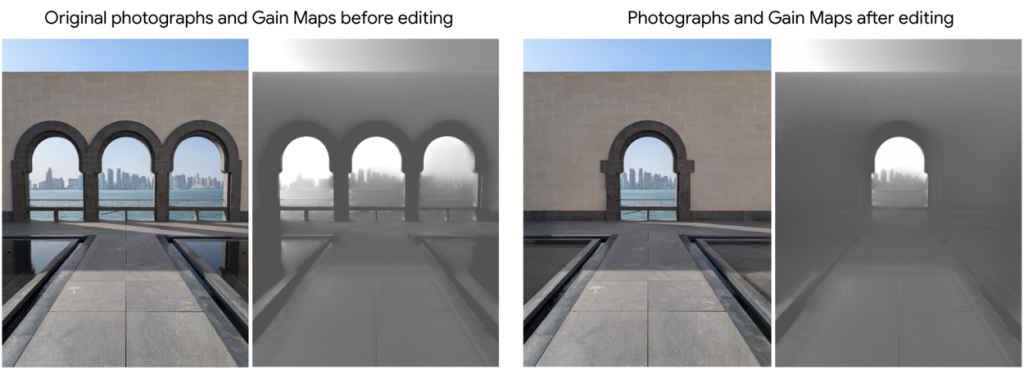

ภาพ Ultra HDR ประกอบไปด้วยข้อมูลสองส่วนแยกกัน ส่วนหนึ่งเป็นไฟล์ภาพ SDR อีกส่วนหนึ่งเป็น gain map ที่บันทึกข้อมูลความสว่างของแต่ละพิกเซลบนภาพนั้น ๆ เก็บอยู่ในเมตาดาตา เมื่อนำทั้งสองส่วนมารวมกันจะกลายเป็นภาพ Ultra HDR หรือ HDR ที่แท้จริง

ภาพ Ultra HDR เกิดจากภาพ SDR รวมกับข้อมูล gain map

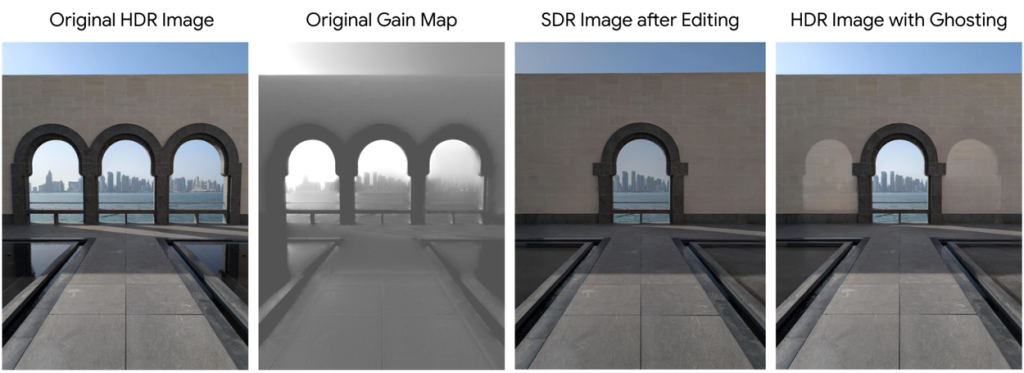

หากทำการแก้ไขภาพ Ultra HDR แบบพื้นฐาน เช่น การหมุนหรือการครอปภาพ โดยทั่วไปจะไม่มีส่งผลกระทบอะไร แต่หากทำการแก้ไขในรูปแบบที่ซับซ้อนกว่านี้ เช่น การลบหรือเติมวัตถุในภาพ ผลลัพธ์อาจออกมาเพี้ยน เพราะจะมีเฉพาะภาพ SDR เท่านั้นที่ได้รับการแก้ไข ในขณะที่ gain map ไม่ได้ถูกแก้ไขไปด้วย

แอปแต่งภาพ ลบวัตถุเฉพาะภาพ SDR แต่ gain map ไม่ได้ถูกแก้ไขตาม

เมื่อนำมารวมกันใหม่ จึงเกิดเป็นภาพซ้อน

หรืออีกกรณีที่เกิดขึ้นได้เช่นกันคือ แอปไม่อ่านข้อมูล gain map แล้วส่งเอาต์พุตออกมาเฉพาะไฟล์ภาพ SDR ธรรมดา กรณีนี้ภาพที่ได้ก็จะไม่ใช่ Ultra HDR อีกต่อไป

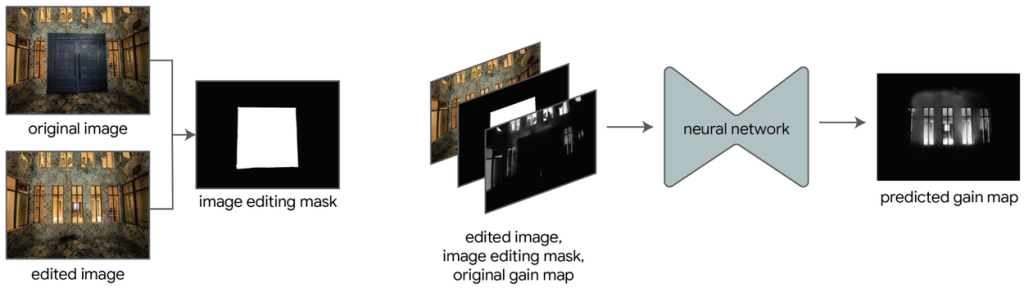

ส่วนเทคนิคที่กูเกิลนำมาใช้แก้ปัญหาข้างต้นคือ การฝึกโมเดล ML ด้วยภาพ Ultra HDR หลายพันใบ จนโมเดลสามารถ ‘คาดการณ์’ การสร้าง gain map ที่สอดคล้องกับความเปลี่ยนแปลงที่เกิดกับภาพ SDR ได้

ML ของกูเกิล สร้าง mask ขึ้นมาเฉพาะจุดที่ภาพ SDR ถูกแก้ไข

จากนั้นจึงสร้าง gain map ที่สอดคล้องกันขึ้นมาใหม่ภายใต้ mask นั้น ๆ

ก่อนนำมารวมเป็นภาพ Ultra HDR ภาพใหม่ที่สมบูรณ์

โมเดลการสร้าง gain map ของกูเกิล มีขนาดเล็กเพียง 1MB เบื้องต้นเปิดให้ทดสอบใช้งานบน Pixel 8 และ Pixel 9 เป็นกลุ่มแรกผ่านแอป Google Photos พร้อมทิ้งท้ายว่าโปรเจกต์นี้ยังอยู่ในช่วงเริ่มต้น บอกเป็นนัยว่าในอนาคตจะมีการปรับปรุงความสามารถเพิ่มเติมให้ผู้ใช้งานสามารถแก้ไขภาพ Ultra HDR ได้ดียิ่ง ๆ ขึ้นไป

ตัวอย่างผลลัพธ์ที่ได้จากพลังของ ML

ที่มา : Google Research

Comment