NVIDIA ค่ายที่ตอนนี้กลายเป็นผู้นำในตลาดชิป AI จากผลงานอันเลื่องชื่ออย่าง H100 ที่หลาย ๆ บริษัท Tech ยักษ์ใหญ่ต่างต้องสั่งซื้อไปใช้ในงานประมวลผลโมเดลภาษาขนาดใหญ่ (LLM) และล่าสุดทางแบรนด์ก็ได้เปิดตัวชิป AI รุ่นใหม่ขั้นกว่า ที่เคลมว่าตัวเองเป็นชิป AI ที่ทรงพลังที่สุดในตลาดตอนนี้ในชื่อ Blackwell B200 GPU ที่ประมวลผล LLM ได้เร็วขึ้นกว่าเดิมถึง 7 เท่า ใช้เทรน AI ได้เร็วขึ้นถึง 4 เท่า

Blackwell B200 GPU เป็นชิปที่ใช้สำหรับงานประมวลผลด้าน AI โดยเฉพาะ ตัวชิปผลิตบนเทคโนโลยีขนาด 4 นาโนเมตรจาก TSMC ซึ่งประกอบไปด้วยทรานซิสเตอร์กว่า 2.08 แสนล้านทรานซิสเตอร์ มากกว่า H100 2.5 เท่า รองรับการประมวลผล AI ได้สูงสุดถึง 20 Petaflops จาก GPU เพียงแค่ตัวเดียว

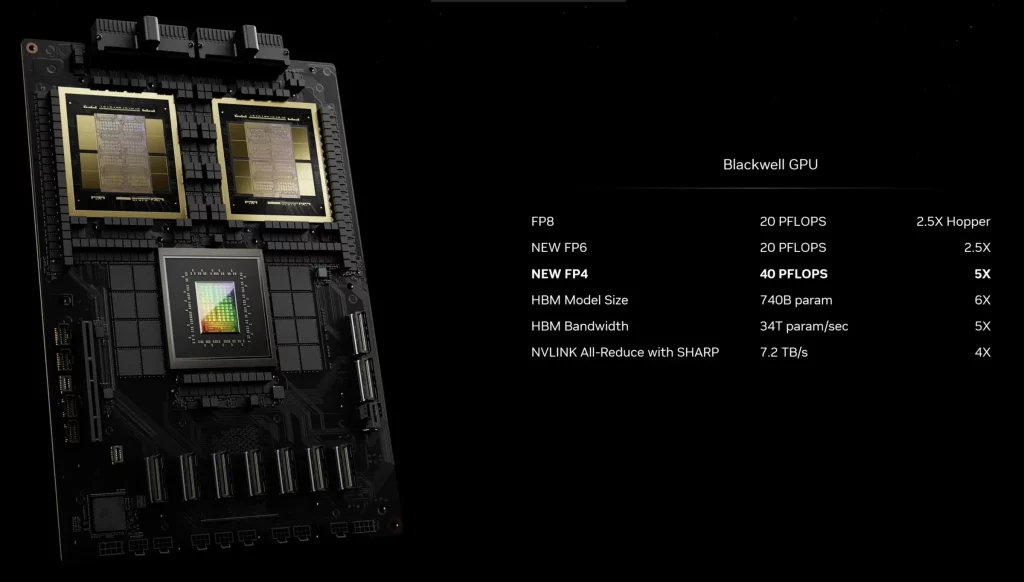

ตัวชิปรองรับชุดคำสั่งชนิดใหม่ FP6 และ FP4 ที่ออกแบบมาเพื่องานด้าน AI โดยเฉพาะ เมื่อเทียบกับการ์ดรุ่นเดิม H100 ด้วยชุดการประมวลผลแบบ FP16 Tensor จะแรงกว่า 2.3 เท่า (H100 ได้ 990 TFLOPS, B200 ได้ 2250 TFLOPS)

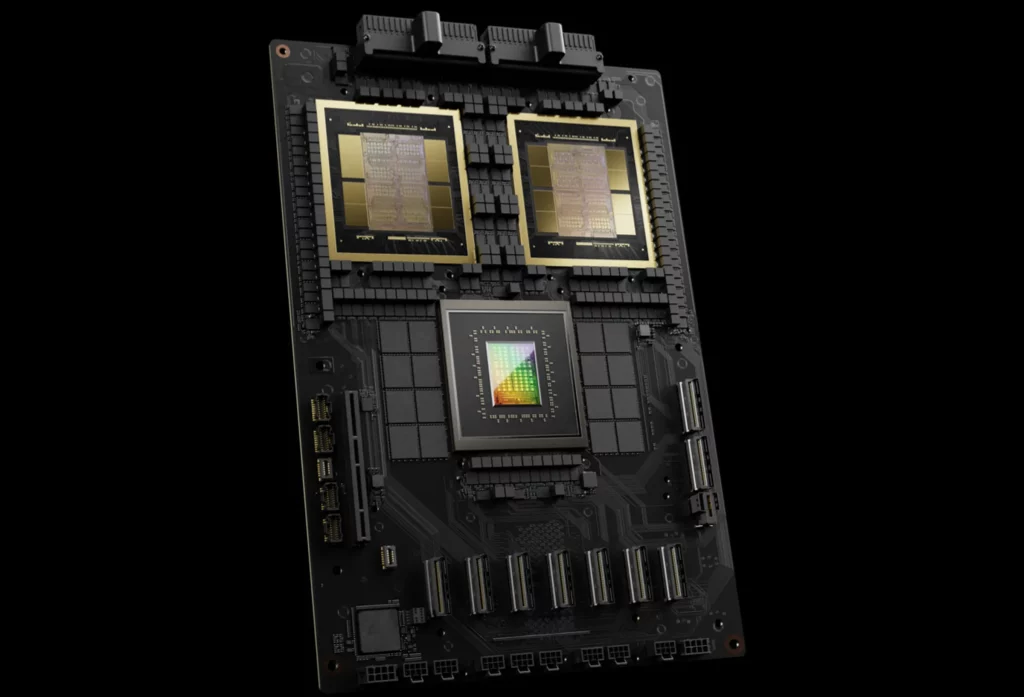

นอกจากนี้เมื่อนำตัวชิป B200 GPU มารวมกัน 2 ตัว + Grace CPU 1 ตัว ก็จะได้เป็น SuperChip ที่ชื่อว่า GB200 จะสามารถประมวลผลคำสั่งบน LLM ได้รวดเร็วขึ้นถึง 30 เท่า รวมถึงลดการใช้พลังงานได้น้อยลงกว่าชิป H100 ถึง 20 เท่า

ในอดีตหากจะเทรนโมเดลภาษา 1.8 ล้านล้านพารามิเตอร์ จะต้องใช้ GPU สถาปัตยกรรม Hopper ที่ใช้ใน H100 กว่า 8,000 ตัว และใช้ไฟฟ้ากว่า 15 เมกะวัตต์ แต่ตอนนี้ทาง NVIDIA เคลมว่าแค่ Blackwell B200 GPU เพียง 2,000 ตัวก็สามารถประมวลผลข้อมูลมหาศาลได้ และใช้ไฟเพียงแค่ 4 เมกะวัตต์เท่านั้น

และเมื่อทดสอบการประมวลผล โมเดลภาษาอย่าง GPT-3 LLM ที่มีขนาด 1.75 แสนล้านพารามิเตอร์ ตัวชิป GB200 สามารถประมวลผลได้เร็วขึ้นกว่าเดิมถึง 7 เท่า และเรียนรู้ได้เร็วขึ้น 4 เท่า เมื่อเทียบกับชิป H100 รุ่นก่อน

แน่นอนว่าทาง NVIDIA ต้องการให้บริษัทต่าง ๆ ซื้อชิปเป็นจำนวนมาก ๆ จึงได้เปินตัวตู้เชิร์ฟเวอร์ B200 NVL72 ที่สามารถใส่ CPU ได้สูงสุด 36 ตัว และ GPU 72 ตัวและมีระบบระบายความร้อนด้วยของเหลวในตัว รองรับการเทรน AI ได้สูงสุด 720 petaflops และประมวลผลคำสั่งได้ 1.4 exaflops

ณ ตอนนี้ทาง NVIDIA ยืนยันแล้วว่าบริษัท Big Tech อย่าง Google, Amazon, Microsoft และ Oracle มีแผนสั่งซื้อเซิร์ฟเวอร์ B200 NVL72 เพื่อใช้กับบริการ Cloud Service ของตัวเอง แต่ยังไม่มีรายละเอียดว่าแต่ละบริษัทได้สั่งซื้อกันไปคนละกี่ตู้ และในอนาคตยังคาดว่าตัวสถาปัตยกรรม Blackwell GPU จะถูกนำมาใช้ในการ์ดจอเล่นเกมอย่าง RTX-50 Series ด้วย

- NVIDIA เผยผลประกอบการไตรมาสที่ 4 ปี 2023 โตขึ้น 265% ฟาดกำไรเหนาะ ๆ 769% จากธุรกิจ Data Center และ AI

- NVIDIA แซง Amazon และ Google Alphabet ขึ้นเป็นบริษัทที่มูลค่าสูงสุดในโลก อันดับ 4

- NVIDIA RTX Remix ซอฟต์แวร์ช่วยม็อดเกมเก่า ใช้ AI แก้ภาพให้สวยขึ้น เปิดให้ใช้งานแบบ Open Beta แล้ว

ที่มา: The Verge

Comment