นับตั้งแต่การเปิดตัวฟีเจอร์ AI Overviews ฟีเจอร์สรุปคำค้นหาหรือสิ่งที่เราต้องการมาให้คนไทยได้ใช้งานกันสักพักแล้ว ภายในงาน Google I/O 2025 ก็ได้มีการประกาศว่า Google จะขยายขอบเขตในการนำ AI โมเดลอย่าง Gemini มาทำให้ Google Search ฉลาดขึ้นกว่าเดิม เพื่อตอบรับกับความต้องการของผู้ใช้ที่เพิ่มมากขึ้น

จาก AI Overviews สู่ AI in Search

AI Overviews คือฟีเจอร์ที่ช่วยให้การค้นหาข้อมูลบน Google เป็นไปอย่างรวดเร็ว ด้วยการดึงข้อมูลจากแต่ละเว็บไซต์มารวมเข้าไว้ด้วยกันแล้วทำเป็นสรุปให้เราอ่าน

ปัจจุบันประเทศใหญ่ๆ อย่างสหรัฐฯ และอินเดีย มีอัตราการใช้งาน Google Search เพื่อค้นหามากขึ้นเรื่อยๆ เลยเป็นหนึ่งในสาเหตุของการพัฒนาฟีเจอร์ใหม่ และนำ AI เข้ามาตอบรับความต้องการที่เพิ่มขึ้นของกลุ่มผู้ใช้งาน ด้วยการนำโมเดลตัวล่าสุด Gemini 2.5 มาใช้กับฟีเจอร์ AI Overviews (เริ่มในสหรัฐอเมริกาก่อน)

ค้นหาข้อมูลแบบใหม่ด้วย AI Mode บน Google Search

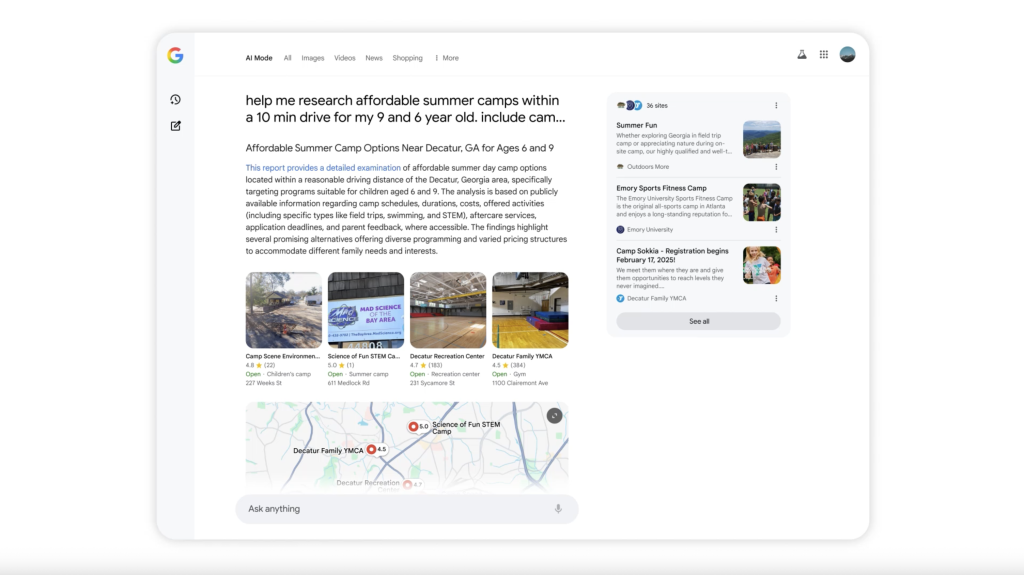

AI Mode คือฟีเจอร์ที่จะทำการ ‘ค้นหาด้วย AI แบบเต็มรูปแบบ’ โดยใช้เทคนิค ‘Query fan-out’ ในการแยกคำค้นหาหรือคำถามของเรา ออกเป็นหัวข้อย่อยหลายร้อยข้อ จากนั้น AI จะส่งคำค้นหาทั้งหมดออกไปพร้อมกันในเวลาเพียงไม่กี่วินาที ช่วยให้ได้คำตอบที่แม่นยำ และครอบคลุมมากกว่าการค้นหาแบบปกติ รองรับคำค้นหาที่ซับซ้อนหรือยาวมากกว่าเดิม 2-3 เท่า

AI Mode จะเปิดให้ผู้ใช้ในสหรัฐอเมริกาทุกคนได้ลองใช้งานกันเป็นประเทศแรก ไม่จำเป็นต้องลงทะเบียนผ่าน Google Labs เหมือนที่ผ่านมา พร้อมกันนั้น Google ยังวางแผนที่จะเปิดตัวความสามารถใหม่ๆ ของ AI Mode เพิ่มเติมอีกในอนาคต ไม่ว่าจะเป็น

Deep Search in AI Mode ค้นหาแบบเจาะลึกละเอียดยิบ

ถ้า AI Mode ยังไม่สะใจพอ ความสามารถของฟีเจอร์ Deep Search จะช่วยให้ได้คำตอบที่เจาะลึก มีความละเอียดและแม่นยำยิ่งกว่าเดิมโดยใช้เทคนิค Query fan-out แบบเดียวกับ AI Mode

Deep Search จะทำการวิเคราะห์คำค้นหาหลายร้อยหลายการพร้อมกัน ประมวลผลข้อมูลทั้งหมดที่ได้มาจากหลายแหล่งข้อมูล แล้วนำมาวิเคราะห์ เรียบเรียงพร้อมสรุปออกมาในรูปแบบของรายงาน แนบด้วยรูปภาพประกอบ ตาราง และแหล่งอ้างอิงแบบครบถ้วน ลดระยะเวลาในการค้นคว้าข้อมูลหลายชั่วโมงให้เหลือเพียงไม่กี่นาที

Search Live ตัวช่วยค้นหาแบบเรียลไทม์

เพื่อยกระดับประสิทธิภาพของการใช้งานการค้นหาด้วยภาพ (Visual Search) Google ได้หยิบความสามารถโต้ตอบแบบเรียลไทม์ของ Project Astra มาใช้กับการค้นหาจนได้เป็นฟีเจอร์ Search Live

Search Live ทำหน้าที่ค้นหาข้อมูล และพูดคุยโต้ตอบกับเราแบบเรียลไทม์อ้างอิงจากสิ่งที่อยู่ในกล้อง ยกตัวอย่างเช่น ‘ทำโปรเจกต์สิ่งประดิษฐ์จากไม้ไอติม แต่ไม่รู้ว่าจะประกอบยังไงให้แข็งแรงที่สุด?’ เพียงแค่เปิดโหมด Live แล้วถามสิ่งที่ต้องการ AI จะตอบกลับเราด้วยเสียงเป็นการอธิบายพร้อมคำแนะนำต่างๆ นอกจากนั้นจะดึงลิงก์ของเว็บไซต์ คลิปวิดีโอ ที่ใช้อ้างอิงให้กดเข้าไปดูเพิ่มได้ด้วย

ปล่อยให้ Search ทำงานแทนเรา

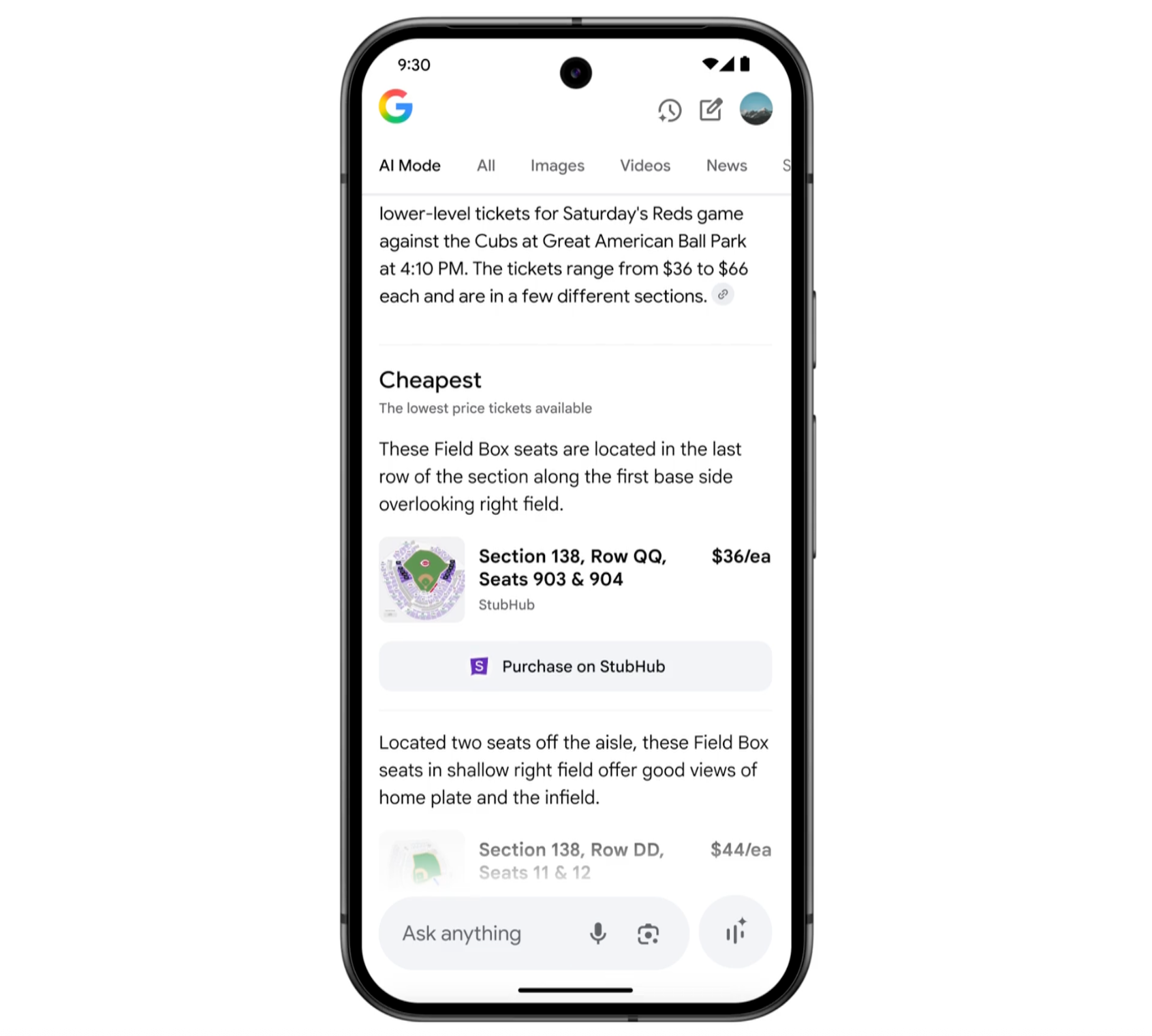

Google นำความสามารถของ Project Mariner ที่มีความสามารถในการ ลงมือทำ มาใช้บน AI Mode ของ Google Search ช่วยให้การค้นหาของผู้ใช้เป็น One-stop Service ครบจบในตัวประหยัดเวลาในการค้นหาและการทำหลายอย่างไปพร้อมกัน

ยกตัวอย่างการค้นหา เช่น “หาตั๋วคอนเสิร์ต PiXXiE ราคาไม่แพง 2 ใบ รอบวันเสาร์นี้เอาเป็นโซนยืน” AI Mode จะทำการค้นหาตามเว็บไซต์ต่างๆ เพื่อวิเคราะห์ตัวเลือกตั๋วคอนเสิร์ตหลายรายการพร้อมราคา และจำนวนที่นั่งที่ดีที่สุด จัดการกรอกข้อมูลให้เสร็จสรรพ จากนั้นจึงสรุปเป็นตัวเลือกตั๋วที่ตรงกับความต้องการของเราให้เลือก พร้อมนำทางไปยังเว็บไซต์ชำระเงินโดยอัตโนมัติ

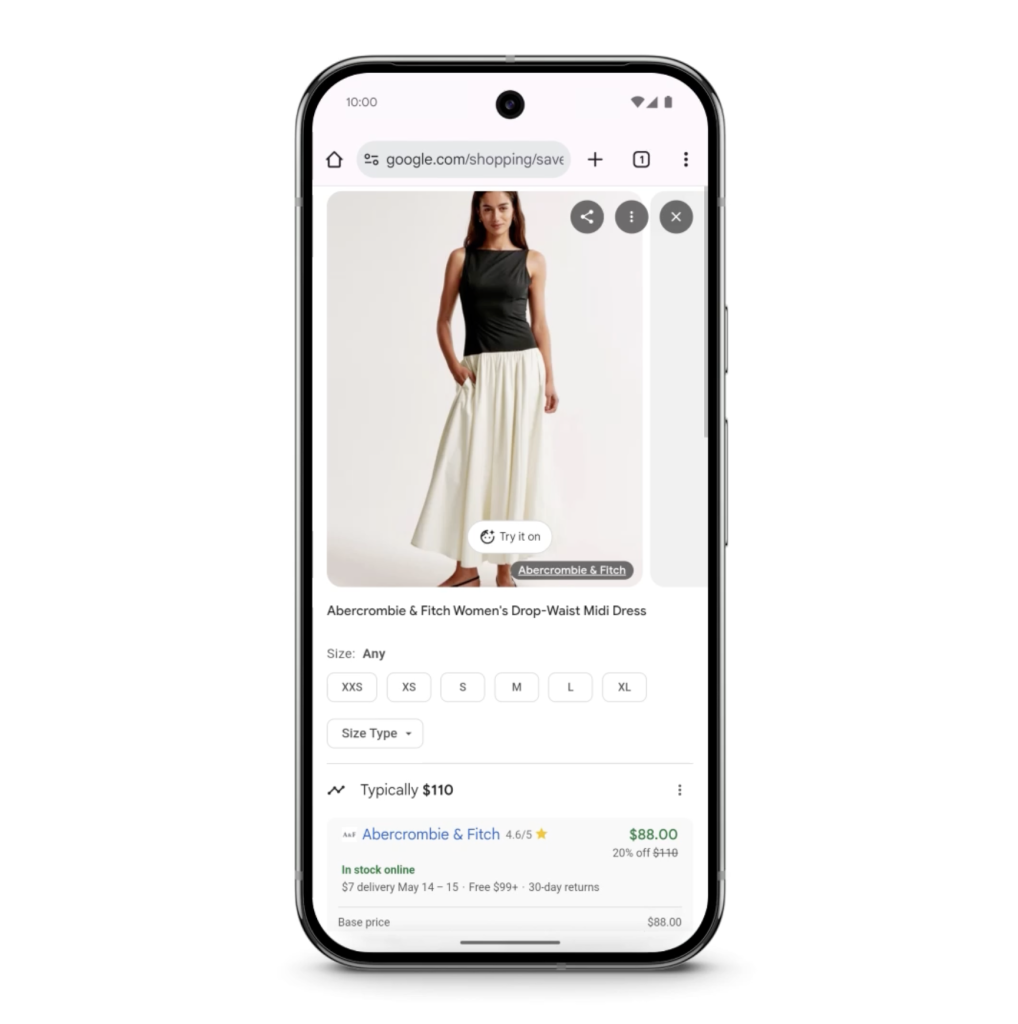

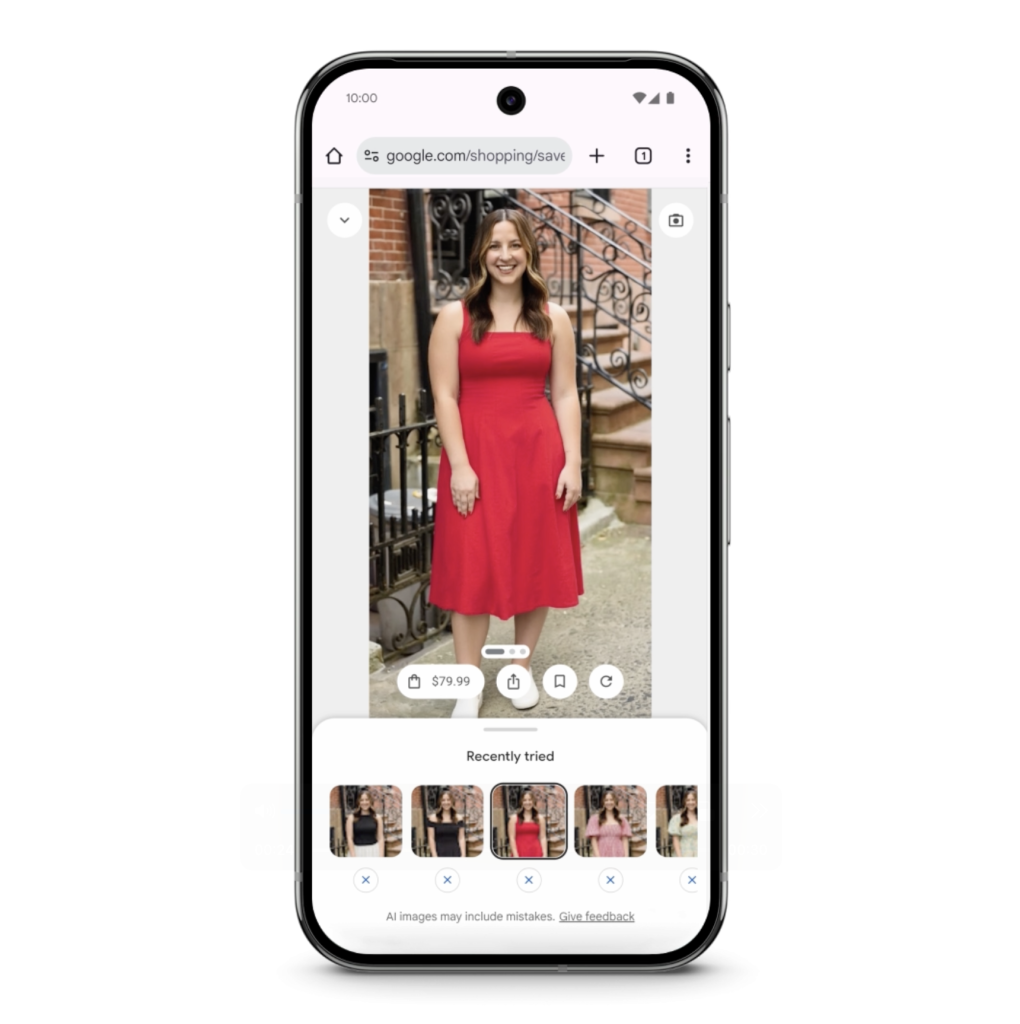

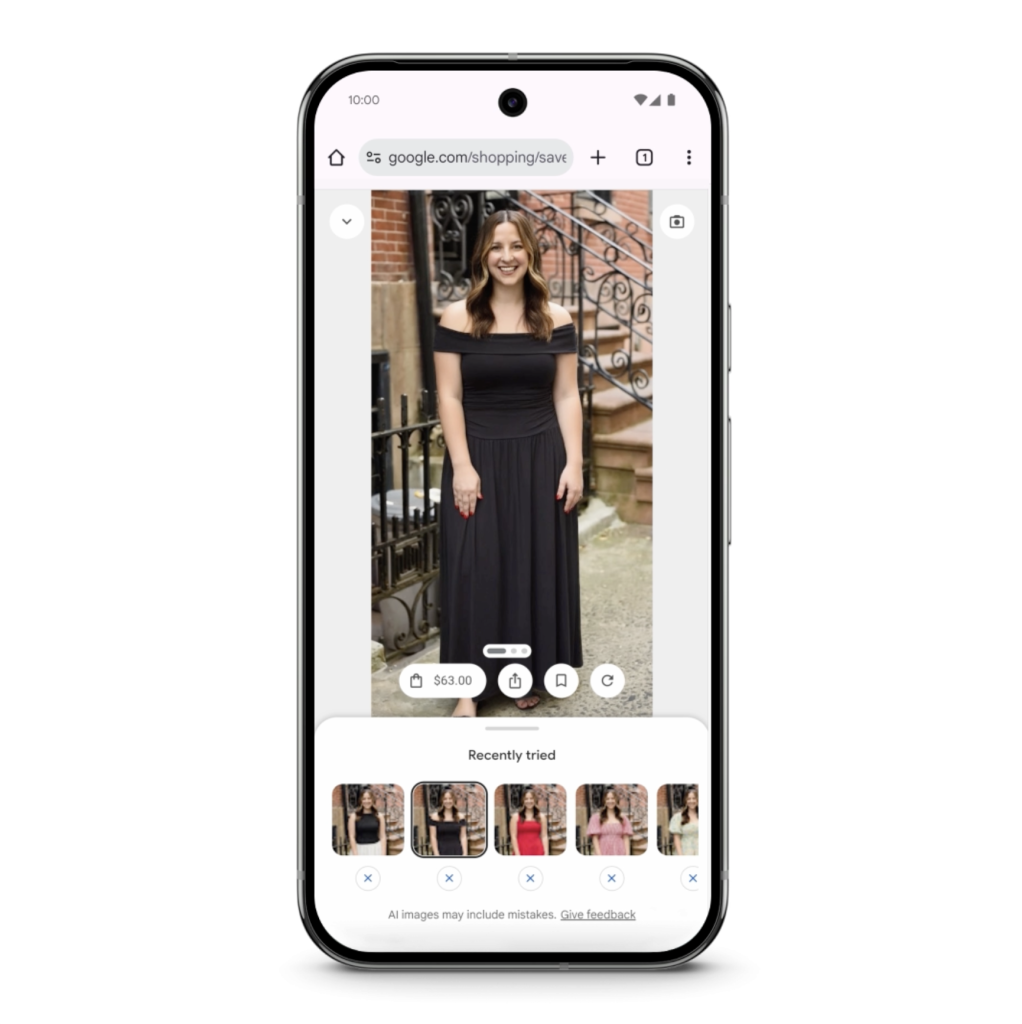

ผู้ช่วยช็อปปิ้งอัจฉริยะ ลองเสื้อผ้าบนเว็บเพิ่มความมั่นใจก่อนกดซื้อ

ช็อปปิ้งออนไลน์ด้วยพลังของ Gemini กับ Google Shopping Graph เปรียบเทียบราคาหรือความแตกต่างสินค้าแต่ละชิ้นง่ายขึ้น หรือถ้าไม่มั่นใจว่าชุดที่เล็งไว้จะเข้ากับตัวเองหรือเปล่า ก็ใช้ฟีเจอร์ Virtual Try-on กับสินค้าในฐานข้อมูลกว่าพันล้านรายการได้เพียงปลายนิ้ว แค่อัปโหลดรูปภาพเต็มตัวของเราหนึ่งรูป (เบื้องต้นยังเปิดให้ทดลองใช้สำหรับสหรัฐอเมริกาบน Google Labs เท่านั้น)

ฟีเจอร์ชำระเงินแบบใหม่ผ่าน Google Payช่วยให้เราซื้อสินค้าในราคาที่ต้องการได้ง่ายๆ แค่กดปุ่ม “ติดตามราคา (track price)” พร้อมจิ้มตัวเลือกไซส์ สี (หรือตัวเลือกอื่นๆ ของสินค้าที่จะซื้อ) และตั้งงบประมาณสำหรับของชิ้นนั้นๆ ระบบจะแจ้งเตือนให้เมื่อสินค้ามีการลดราคาไปจนถึงเป้าหมายที่เราตั้งไว้

ระบบ Search ที่ออกแบบมาให้เข้าใจเรามากกว่าเดิม

เพื่อให้การค้นหาคอยแนะนำผลลัพธ์ที่เหมาะสมกับไลฟ์สไตล์ของเรา AI Mode จะคอยให้คำแนะนำที่ออกแบบมาสำหรับเราโดยเฉพาะ (personalized suggestions) โดยอิงจากประวัติการค้นหา และข้อมูลต่างๆ บน Google Service ของเรา เช่น Gmail และ Calendar เป็นต้น AI จะเข้าใจว่าเรามีไลฟ์สไตล์แบบไหน ทำงานหรือจำเป็นต้องใช้ข้อมูลประเภทใดมากที่สุด

เปรียบเทียบข้อมูลที่ซับซ้อนให้อยู่ในรูปแบบกราฟที่เข้าใจง่าย

อีกหนึ่งความสามารถของ AI Mode in Search คือการสรุปข้อมูล และรองรับชุดข้อมูลตัวเลขที่ซับซ้อนเพื่อทำภาพหรือกราฟเปรียบเทียบให้เราดูแบบง่ายๆ ไม่ว่าจะเป็นเรื่องกีฬาหรือการเงิน Search จะดึงข้อมูลแบบเรียลไทม์จาก Google มาสรุปให้เราโดยไม่ต้องวิเคราะห์เองให้ยุ่งยาก เช่น เปรียบเทียบข้อมูลอัตราการชนะ-แพ้ ของทีมที่ชื่นชอบกับทีมอื่นๆ

Gemini in Chrome

อีกหนึ่งสิ่งที่จะไม่พูดถึงก็ไม่ได้คือการมาถึงของ Gemini บน Google Chrome สำหรับผู้ใช้งานแพ็คเกจ Google AI Pro และ Google AI Ultra ที่จะฝังมาในรูปแบบของปุ่มใหม่ปรากฏอยู่ตรง Title Bar มีความสามารถในการอ่าน สรุปหรือเรียบเรียงเนื้อหาจำนวนมากบนหน้าเว็บที่เราดู รองรับหน้าต่างสำหรับการถาม-ตอบ และในอนาคต Google มีแผนขยายความสามารถของ Gemini บน Chrome เพิ่มเติม เช่น การทำงานระหว่างแท็บหรือการท่องเว็บแทนผู้ใช้

สำหรับ AI Mode และความสามารถอื่นๆ ที่มาพร้อมกันตามลิสต์ข้างบน จะเริ่มเปิดให้ใช้งานสำหรับกลุ่มผู้ใช้ในสหรัฐอเมริกาเป็นประเทศแรก สำหรับประเทศอื่นๆ คาดว่าอาจจะทยอยเปิดตัวให้ใช้งานไม่เกินภายในสิ้นปี 2025 นี้ครับ

ที่มา: Google

เนื้อหาที่เกี่ยวข้อง

Comment