ChatGPT ถึงแม้จะปาดหน้าเปิดตัวโมเดล GPT-4o ที่สามารถพูดโต้ตอบ อ่านภาพผ่านกล้องได้รวดเร็ว และเป็นธรรมชาติก่อน Google เพียงหนึ่งวัน แต่ Google ก็งัดไม้เด็ดมาต่อกรด้วย Project Astra ซึ่งเป็นฟีเจอร์บนแอป Gemini ที่ทำได้ทุกอย่างเหมือนที่ GPT-4o ทำได้ และยังฉลาดไม่แพ้กันด้วย แต่จะได้ใช้เมื่อไหร่ Google ยังไม่ตอบมาชัด ๆ ในตอนนี้

ภายในงาน Google I/O 2024 ได้มีการนำวิดีโอสาธิตการใช้งาน Project Astra มาโชว์ให้สื่อได้ชมกันในงาน ซึ่งตัวโปรเจกต์นี้มาในลักษณะแอปผู้ช่วย AI อัจฉริยะในรูปแบบ multi-modal ที่สามารถเข้าใจบริบท และประมวลได้ทั้งภาพ เสียง และบทสนทนาต่าง ๆ ผ่านการใช้กล้องมือถือ หรือกล้องบทแว่น AR Glass มาเป็นดวงตาให้กับ AI และใช้ Gemini AI โมเดลล่าสุดในการประมวลผล

Project Astra ถูกออกแบบมาให้ประมวลผลวิเคราะห์ข้อมูลภาพ และเสียงได้ในแบบ Real-Time อีกทั้งยังสามารถจดจำรายละเอียดต่าง ๆ ในสิ่งที่ผ่านตาไปแล้วได้เป็นอย่างดี ซึ่งในระหว่างการใช้งานตัวระบบจะมีการถอดรหัสเฟรมในวิดีโอ รวมภาพเคลื่อนไหวและเสียงที่ถูกป้อนเข้ามา พร้อมจัดเรียงไทม์ไลน์ของเหตุการณ์อยู่ตลอด เพื่อให้ระบบเรียกใช้ข้อมูลเก่าที่ถูกบันทึกได้อย่างรวดเร็ว

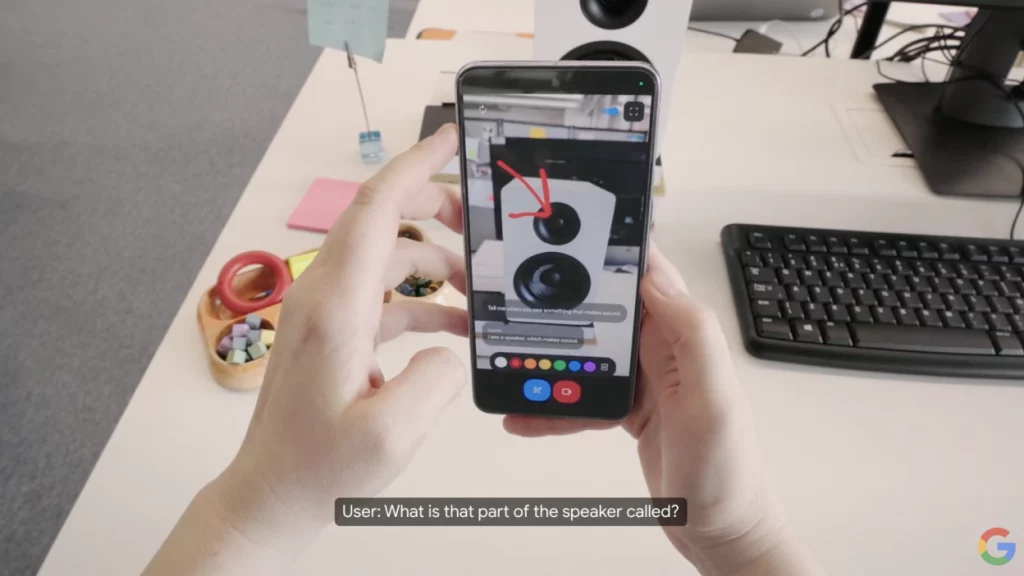

ในวิดีโอสาธิตดังกล่าว Google ยังได้เคลมด้วยว่า การถ่ายทำทุกอย่างเกิดขึ้นแบบ Real-Time และถ่ายทำเพียงแค่เทคเดียว ซึ่ง Project Astra ก็ได้โชว์ความสามารถด้วยการอธิบายชิ้นส่วนของลำโพง เมื่อผู้สาธิตนำกล้องไปจ่อที่วัตถุดังกล่าว พร้อมถามคำถาม และวาดลูกศรระบุตำแหน่งว่าชิ้นส่วนของลำโพงในตำแหน่งนั้นเรียกว่าอะไร ซึ่ง AI ก็ตอบกลับมาได้อย่างถูกต้องทันที

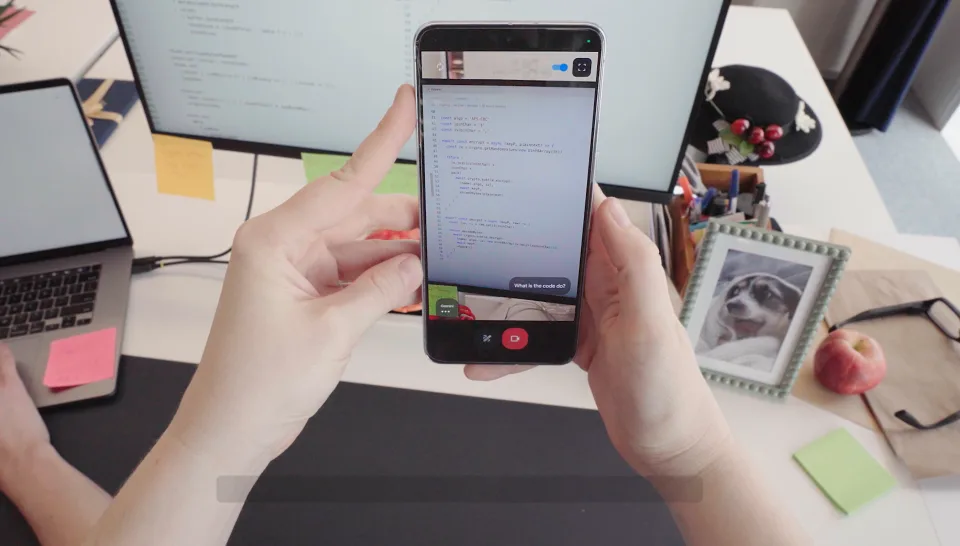

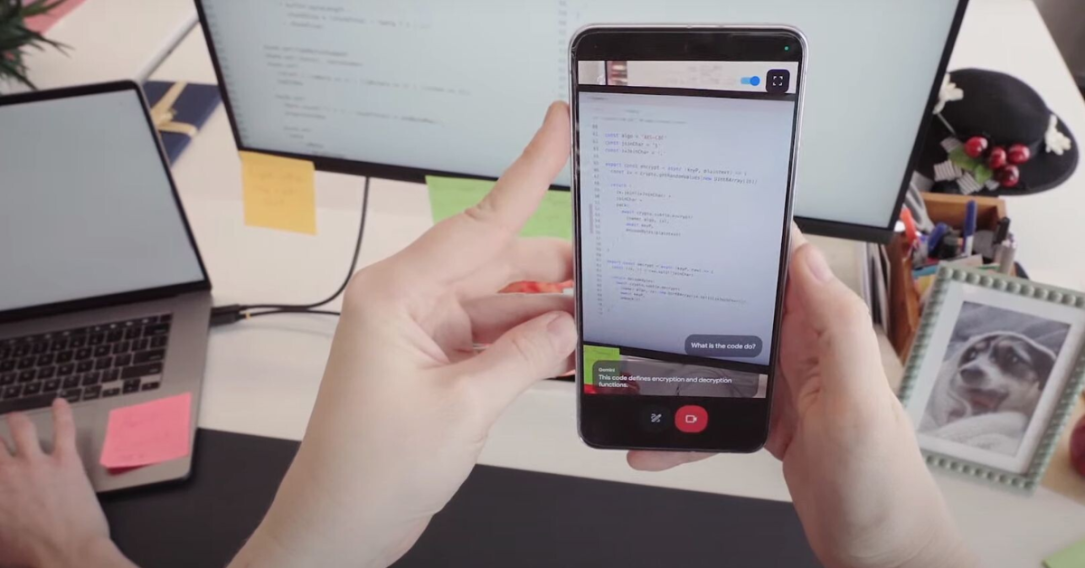

นอกจากนี้ Project Astra ยังสามารถระบุได้ว่าผู้ใช้งานกำลังอยู่ในย่านไหน เพียงแค่จ่อกล้องไปยังนอกหน้าต่าง รวมถึงเมื่อจ่อไปที่โปรแกรมเขียนโค้ดบนคอมพิวเตอร์ ก็สามารถตอบผู้ใช้งานได้ว่าโค้ดที่ปรากฏอยู่บนจอทำหน้าที่อะไร อีกทั้งยังได้นำ Project Astra มาใช้งานร่วมกับแว่น AR ปริศนาที่ยังไม่เคยเปิดตัวด้วย

อย่างไรก็ตาม Project Astra เป็นเพียงแค่การสาธิตฟีเจอร์ต้นแบบให้ดูแบบคร่าว ๆ ยังไม่มีแผนจะเปิดให้ใช้งานจริงในเร็ว ๆ นี้ แต่ความสามารถบางอย่างของโปรเจกต์นี้จะถูกนำมาใส่ในแอป Gemini และเปิดให้ใช้งานบนมือถือ Google Pixel ภายในปี 2024

- รวม 5 ฟีเจอร์ AI ใหม่บน Android ที่เตรียมอัปเดตให้ใช้งานในปี 2024 มี AI ช่วยตรวจจับมิจฉาชีพในสายแบบไม่ต้องต่อเน็ต

- Google อัปเดต Gemini 1.5 Pro ฉลาดขึ้น ฟังเสียงได้ – พร้อมออก Gemini 1.5 Flash โมเดลใหม่ ทำงานไวกว่าเดิม

- Google เปิดตัว 2 โมเดล AI ใหม่ Imagen 3 ช่วยสร้างรูป, VEO สร้างวิดีโอคมชัด 1080p และเปิดบริการ Music AI Sandbox

ที่มา: Engadget

Comment