Google เปิดตัว Gemini ที่เป็น large language model (LLM) ของค่ายมาครบ 5 เดือน วันนี้ Google ประกาศอัปเดตเป็น Gemini Pro เป็น Gemini 1.5 Pro จุดสำคัญคือการเพิ่มการรองรับ context window เป็น 2 ล้านโทเคนเป็นครั้งแรก สูงกว่า GPT-4 ของคู่แข่งเกือบ 16 เท่า และเพิ่มการรองรับการทำความเข้าใจกับอินพุตที่เป็นเสียง พร้อมปรับปรุงประสิทธิภาพการแปล การเขียนโค้ด การใช้เหตุผล และอื่น ๆ ให้รองรับการสั่งงานที่ซับซ้อนกว่าเดิม

ลงทะเบียน waitlist ทดลองใช้งาน Gemini 1.5 เวอร์ชัน 2 ล้านโทเคนได้ที่ ai.google.dev/gemini-api

ขณะเดียวกัน Google ก็ได้เพิ่ม Gemini 1.5 Flash มาอีก 1 โมเดล ชูจุดขายว่าเป็นโมเดลขนาดเล็ก ทำงานได้ไว ตรงตามชื่อ ‘flash’ ทำให้ Gemini ตอนนี้มีโมเดลรวม 4 ขนาดแล้ว คือ

- Gemini Flash (ใหม่)

- Gemini Nano

- Gemini Pro

- Gemini Ultra

เบื้องต้น Google เปิดให้ทดสอบ Gemini 1.5 Pro และ Gemini 1.5 Flash แล้วใน Google AI Studio และ Vertex AI สำหรับลูกค้า Google Cloud แต่ยังเป็นเวอร์ชัน 1 ล้านโทเคนก่อน ส่วนเวอร์ชัน 2 ล้านโทเคนจะเปิดให้ทดสอบตามมาในภายหลัง

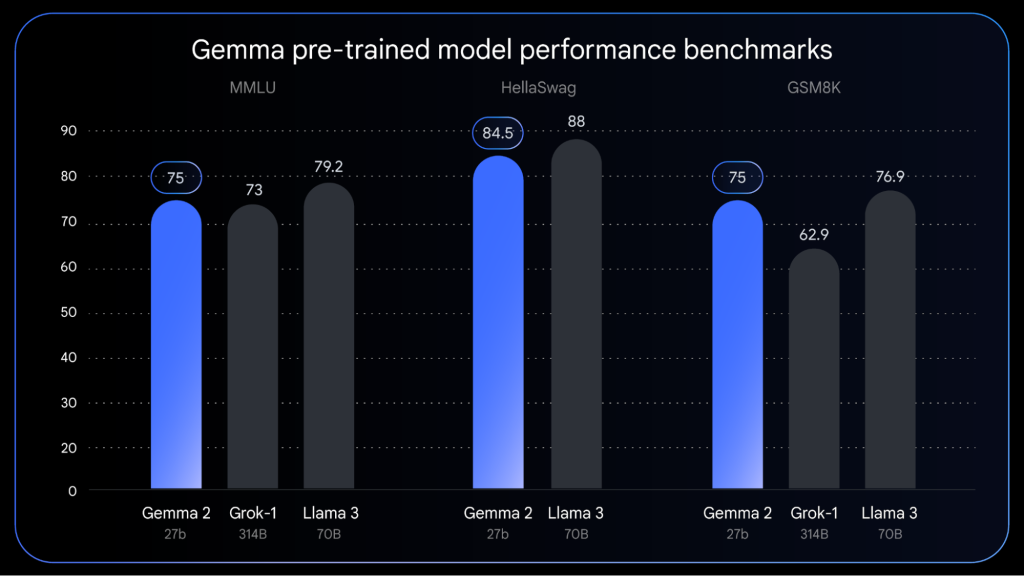

ของใหม่ที่เปิดตัวพร้อมกันวันนี้มีเพิ่มเติมอีกสองอย่าง อย่างแรกคือ Gemma 2 พร้อมโมเดล Gemma 27B ที่ Google บอกว่านักพัฒนาหลายรายเรียกร้องกันมานาน ก็เลยจัดให้ตามคำขอ (ของเดิมมี Gemma 2B กับ Gemma 7B ที่หลายคนบอกว่าไม่พอใช้งาน) โดย Google เคลมว่า Gemma 27B มีประสิทธิภาพเทียบเท่า Llama 3 70B ของ Meta ในขนาดที่เล็กกว่ากันแบบครึ่งต่อครึ่ง

อย่างถัดมาคือ PaliGemma ที่เป็น vision-language open model (VLM) ตัวแรกในตระกูล Gemma ที่ได้แรงบันดาลใจมาจาก PaLI-3 เก่งในเรื่องการทำความเข้าใจและสร้างคำอธิบายให้กับรูปภาพและวิดีโอ รวมถึงการตอบคำถามด้วยรูปภาพ

เช่นเดียวกับ Gemini 1.5 Pro และ Gemini 1.5 Flash คือ Google จะเปิดให้ลูกค้า Google Cloud ทดสอบใช้งาน PaliGemma ก่อนใน Vertex AI ตั้งแต่วันนี้เป็นต้นไป ส่วน Gemma 27B จะตามมาภายหลังช่วงฤดูร้อน ยังไม่ระบุวันที่ชัดเจน

Comment