รู้หรือไม่ว่า Google Assistant ที่ผู้อ่านหลายๆคนอาจจะได้สัมผัสกันผ่านมือถือกันมากบ้างแล้ว ในอนาคตมันจะทำอะไรได้อีกมากมายหลายอย่างเลยนะ ซึ่งส่วนหนึ่งก็ถูกพูดถึงในงาน Google Developer Days Europe 2017 ที่เพิ่งจัดขึ้นมาเมื่อไม่นานนี้นี่เอง

https://photos.app.goo.gl/R2MMMlHTSylbBSY62

งาน Google Developer Days Europe 2017 เป็นหนึ่งในงาน Conference ของ Google ที่คล้ายกับ Google I/O แต่มีขนาดไม่ใหญ่มากนัก และเพิ่งจะจบไปไม่นานนี้ (ผมก็เพิ่งจะกลับมาจากงานนี้เช่นกัน) ซึ่งใน Keynote ของงานวันที่ 2 ได้พูดถึงความสามารถใหม่ๆใน Google Assistant ที่น่าสนใจ ซึ่งผมคิดว่ามันเป็นฟีเจอร์ที่น่าสนใจมากสำหรับฝั่งผู้ใช้ทั่วๆไป จึงหยิบมาอัพเดทให้ได้อ่านกันครับ

หลายๆคนคงรู้กันแล้วว่าในตอนนี้ Google ได้พุ่งเป้าหมายไปที่ AI เป็นหลักแล้ว ดังนในปัจจุบันก็ได้มี Product หลายๆตัวของ Google ที่ถูกผนวกเข้ากับเทคโนโลยีทางด้าน AI ของ Google ที่เห็นได้ชัดที่สุดสำหรับผู้คนทั่วไปก็คงจะเป็น Google Assistant ที่ผู้อ่านหลายๆคนได้ลองใช้งานกันบ้าง (จริงๆแล้วมี Product อีกหลายๆตัวของ Google ที่มีการใช้ AI หรือ Machine Learning เข้ามาใช้โดยที่ผู้ใช้ไม่รู้ตัวเลย)

ถ้าใครได้ลองใช้งานเจ้า Google Assistant ผ่านมือถือหรือ Google Home ก็คงจะรู้สึกว่ายังไม่ว้าวอะไรมากนัก เมื่อเทียบกับลูกเล่นในการโต้ตอบอย่าง Siri แต่ก็ต้องบอกเลยว่าเรื่องความสามารถในการพูดคุยกับผู้ใช้ของ Google Assistant นั้นมีแนวโน้มในการพัฒนาที่ดีกว่ามาก โดยมีหัวใจสำคัญคือ Conversation หรือบทสนทนาระหว่างผู้ใช้กับ Google Assistant

เข้าใจบทสนทนาและสามารถโต้ตอบได้ต่อเนื่องและเป็นธรรมชาติมากขึ้น

เราอาจจะคุ้นเคยกับบทสนทนาง่ายๆอย่าง “ภูเขาไฟฟูจิสูงเท่าไร” หรือ “โลกอยู่ห่างกับดวงจันทร์เท่าไร” กันมาบ้างแล้ว แต่ในความเป็นจริงบทสนทนาเหล่านี้เป็นแบบ “ถามคำ-ตอบคำ” ที่ไม่ได้ทำให้รู้สึกว่าเราพูดคุยอยู่จริงๆซักเท่าไร ซึ่งในแต่ละครั้งที่เราพูดหรือถามอะไรก็ตาม Google Assistant จะพยายามเรียนรู้อยู่เสมอว่า Context หรือบริบทของบทสนทนานั้นคืออะไร และนำ Context นั้นๆไปเชื่อมเข้ากับประโยคต่อไปเพื่อให้สามารถเข้าใจคำถามของผู้ใช้มากขึ้นและเป็นธรรมชาติมากขึ้น (เดิมทำได้อยู่แล้ว แต่มีการปรับปรุงให้ดียิ่งขึ้น)

ปกติแล้วเวลาพูดคุยกับระบบ Assistant เราจะต้องถามคำถามแบบนี้

- ตึกเอ็มไพร์สเตตอยู่ที่ไหน?

- แสดงภาพตึกเอ็มไพร์สเตตให้ดูหน่อย

- ตึกเอ็มไพร์สเตตสูงเท่าไร?

- ใครสร้างตึกเอ็มไพร์สเตต?

- ตึกเอ็มไพร์สเตตถูกสร้างขึ้นมาเมื่อไร?

ความไม่เป็นธรรมชาติในประโยคแบบนี้ก็คือ ผู้ใช้ต้องพูดถึงบริบทอยู่ทุกครั้ง เพื่อให้ระบบรับรู้ว่าเรากำลังพูดถึงอะไรอยู่ ซึ่งในที่นี้คือ “ตึกเอ็มไพร์สเตต”

แต่สำหรับ Google Assistant นั้นจะคอยรับรู้อยู่เสมอว่าบริบทที่เราพูดอยู่ในแต่ละประโยคคืออะไร โดยอ้างอิงจากประโยคก่อนหน้าหรือข้อมูลที่เกี่ยวข้องกับผู้ใช้ ดังนั้นคุณสามารถพูดแบบนี้ได้เลย

- ตึกเอ็มไพร์สเตตอยู่ที่ไหน?

- แสดงภาพให้ดูหน่อย

- สูงเท่าไร?

- ใครสร้าง?

- เมื่อไร?

- มีร้านอาหารอิตาเลียนแถวๆนั้นมั้ย?

- โทรหาร้านอาหารร้านแรกสุด

(ดูได้จากวีดีโอ Keynote ช่วงนาทีที่ 50:15)

และการรับรู้ถึงบริบทของบทสนทนานั้นจะช่วยให้ Google Assistant สามารถตอบกลับด้วยผลลัพธ์ที่ตรงกับความต้องการของผู้ใช้มากขึ้น เช่น ถ้าเราบอกกับมันว่า “แสดงภาพโธมัส” ก็จะแสดงภาพโดยใช้คีย์เวิร์ดในการค้นหาว่า “โธมัส” แต่ถ้าเราบอกว่า “รายชื่อนักเตะในทีมบาเยิร์นมิวนิก” แล้วตามด้วย “แสดงภาพโธมัส” เราก็จะได้ผลลัพธ์เป็นภาพของโธมัส มุลเลอร์ที่เป็นนักเตะของทีมนี้ (ดูได้จากวีดีโอ Keynote ช่วงนาทีที่ 49:20)

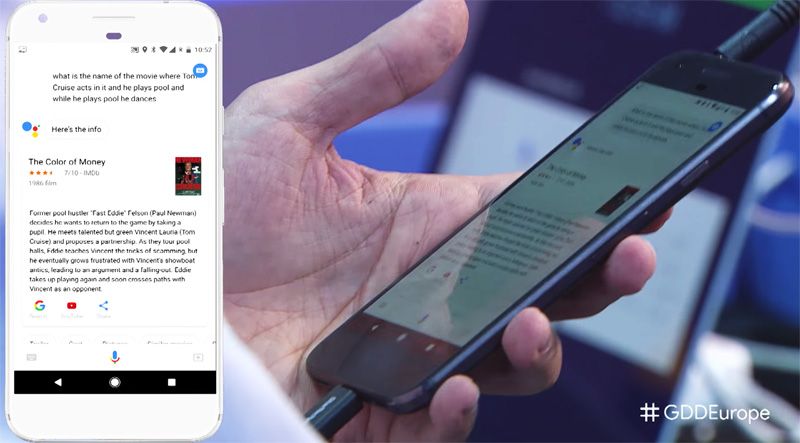

เข้าใจคำถามที่ซับซ้อนได้มากขึ้น

ซึ่งใน Keynote ได้แสดงให้เห็นถึงความสามารถนี้ด้วยการถามว่า “What is the name of the movie there Tom Cruise acts in it and he plays pool and while he plays pool he dances. – ภาพยนตร์อะไรที่ทอมครูซแสดงและมีฉากที่เขาเล่นพูลและระหว่างที่เขาเล่นพูล เขาก็เต้นด้วย” และ Google Assistant ก็ตอบกลับมาแบบสบายๆว่าเรื่อง The Color of Money (ดูได้จากวีดีโอ Keynote ช่วงนาทีที่ 41:09)

อันนี้ทำเอาผมอึ้งเหมือนกัน เพราะนอกจากแสดงถึงความสามารถของ Google Assistant แล้ว ยังแสดงไปถึงความสามารถในการเรียนรู้ในระบบหลังบ้านของ Google Assistant ด้วย เพราะมันเป็นข้อมูลที่เจาะลึกลงไปในเนื้อหานั้นๆหรือก็คือมันต้องเรียนรู้ถึงฉากต่างๆที่อยู่ในภาพยนตร์ได้นั่นเอง

เรียนรู้และจดจำข้อมูลของผู้ใช้ได้

โดยปกติแล้ว Google Assistant จะมีข้อมูลของผู้ใช้จากเหล่าบรรดาแอปฯของ Google อยู่แล้ว ไม่ว่าจะเป็น Gmail, Calendar หรือแม้แต่ Google Account เองก็ตาม แต่ในอนาคตเราจะสามารถสอน Google Assistant ได้เลยว่าเราชอบอะไร ทำอะไร หรือมีเงื่อนไขอะไร เพื่อให้ Google Assistant นำไปเก็บเป็นข้อมูลเพื่อใช้พูดคุยและตอบคำถามกับเราในภายหลัง เช่น

- ผู้ใช้ : “When the weather is more than 25 degrees I can swim in the lake of Zurich – ผมสามารถว่ายน้ำในทะเลสาบซูริคได้ก็ต่อเมื่อสภาพอากาศมีอุณหภูมิมากกว่า 25 องศาเซลเซียส”

- Google Assistant : “Ok, understood – โอเค เข้าใจแล้ว”

- ผู้ใช้ : “Can I swim in the lake of Zurich this weekend? – วันหยุดสุดสัปดาห์นี้ผมสามารถว่ายน้ำในทะเลสาบซูริคได้หรือป่าว?”

- Google Assistant : “No, you can’t. The temperature is less than 25 degrees – ไม่ได้ เพราะว่าสภาพอากาศมีอุณหภูมิต่ำกว่า 25 องศาเซลเซียส”

รองรับการทำงานร่วมกับแอปฯต่างๆมากขึ้น

ในตอนที่ Google Assistant เปิดตัวใหม่ๆนั้น ต้องบอกเลยว่ายังมีความสามารถไม่มากเท่าที่ควรจะเป็น เพราะว่า Google Assistant นั้นเปิดให้นักพัฒนาสามารถใช้งานได้ด้วย ดังนั้นจึงต้องใช้เวลาพักหนึ่งเพื่อให้บริษัทหรือแอปฯต่างๆรองรับและทำงานกับ Google Assistant ได้มากขึ้น ซึ่งภายในงานก็ได้แสดงการทำงานของ Google Assistant ร่วมกับ Google Translator และ Google Street View

แปลภาษาในตัวได้เลย

เพียงแค่เราบอกกับ Google Assistant ว่าจะให้แปลภาษาอะไร ด้วยคำสั่ง “Be my …ภาษาที่ต้องการแปล… translator” เช่น “Be my Vietnamese translator” จากนั้นเมื่อพูดประโยคอะไรก็ตาม เจ้า Google Assistant ก็จะตอบกลับมาเป็นภาษานั้นๆให้ทันที และเมื่อต้องการให้หยุดแปลก็เพียงแค่บอกว่า “Stop translation” (ดูได้จากวีดีโอ Keynote ในนาทีที่ 42:09)

ทำงานร่วมกับ Google Lens ได้มากขึ้น

สามารถถามคำถามกับ Google Assistant โดยมีภาพจาก Google Lens ได้ แล้ว Google Assistant รู้เองได้ว่าภาพจากกล้องนั้นคืออะไร และจะตอบคำถามเราได้อย่างไร เช่น

- ผู้ใช้ : ส่องกล้องไปที่ลูกแอปเปิล แล้วถามว่า “How many calories does it have? – มันมีกี่แคลอรี”

- Google Assistant : “There are 95 calories in 1 medium apple – แอปเปิลขนาดปกติ 1 ผล มี 95 แคลอรี”

หรือ

- ผู้ใช้ : เอากล้องส่องธนบัตรที่วางอยู่บนโต๊ะ แล้วถามว่า “How much is this in Swiss Franc? – เป็นจำนวนเงินเท่าไรในสกุลเงินฟรังก์สวิส”

- Google Assistant : “250 Polish Zloty equals 67 Swiss Francs and 10 Rappen – 250 Polish Zloty เท่ากับ 67.10 ฟรังก์สวิส”

(ดูได้จากวีดีโอ Keynote ในนาทีที่ 52:18)

ฟังคำพูดได้ดีขึ้น ลดเสียงรบกวนให้น้อยลง

นอกเหนือจากคุณภาพของไมค์ในตัวอุปกรณ์แล้ว เจ้า Google Assistant ก็มีระบบวิเคราะห์เสียงที่มีการใช้ Machine Learning ในการสอนให้มันรู้ว่าอันไหนคือเสียงผู้ใช้จริงๆ อันไหนคือเสียงรบกวนจากสภาพแวดล้อมรอบๆ เพื่อให้รับรู้คำพูดได้แม่นยำและถูกต้องมากขึ้น

และนี่ก็คือส่วนหนึ่งในความสามารถของ Google Assistant ที่ทีมพัฒนาของ Google กำลังพัฒนากันอยู่เพื่อเพิ่มความสามารถของ Google Assistant ให้ดีมากขึ้น มีความเป็นธรรมชาติมากขึ้น และตอบโจทย์ความต้องการของผู้ใช้งานได้มากขึ้นนั่นเอง

ก็ต้องรอติดตามดูกันต่อไปว่าเจ้า Google Assistant นั้นสามารถพัฒนาไปได้อีกมากขนาดไหน และจะช่วยให้เราสะดวกสบายมากขึ้นได้อย่างไร แต่ที่แน่ๆก็คือยังไม่รองรับภาษาไทยเลยจ้าาาาาาา

แหล่งข้อมูลอ้างอิง : Phone Arena

ยุคสมัยของ AI กำลังอยู่ไม่ไกลแล้ว 😆