เก็บตกประเด็นหลังงาน WWDC24 เพิ่มเติม หลัง Apple เปิดตัว iOS 18 โดยมี Apple Intelligence เป็นพระเอก ทว่า ฝั่งมือถือมีเพียง iPhone 15 Pro และ iPhone 15 Pro Max เท่านั้นที่ได้ใช้ อนาคตจะเป็นอย่างไรคงไม่อาจทราบ แต่ปัจจุบัน iPhone ที่เหลืออีก 20 กว่ารุ่น โดนปล่อยแห้ง ตกรถด่วนขบวน AI ไปแล้ว iPhone 15 และ iPhone 15 Pro จากซีรีส์เดียวกันก็ไม่ใช่ข้อยกเว้น นำไปสู่คำถามที่ว่า เหตุใดจึงเป็นเช่นนั้น ? วันนี้ DroidSans จะพาผู้อ่านมาหาคำตอบไปพร้อมกันในบทความนี้

ชิปแรงไม่พอ หรือแอปเปิลแค่อยากกั๊ก

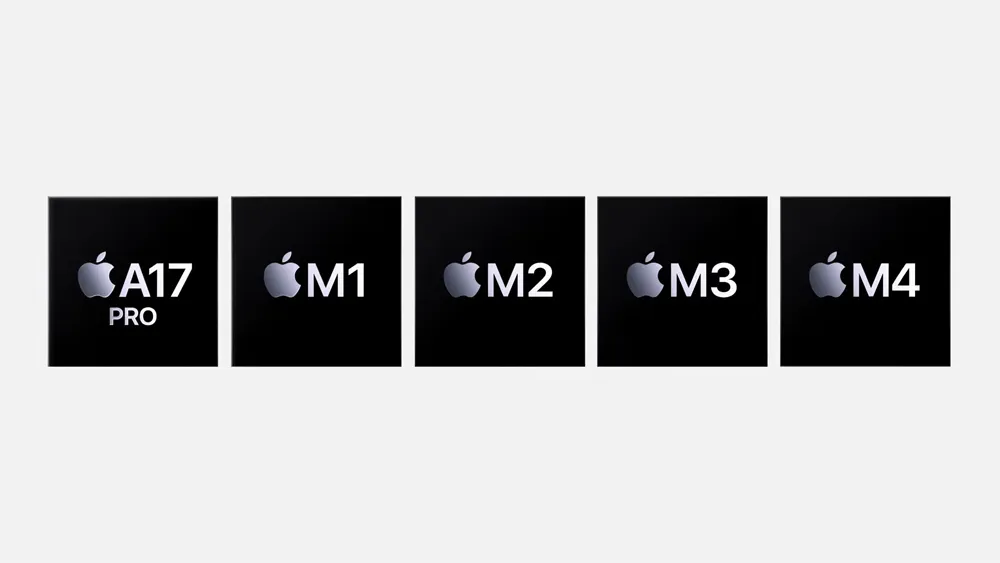

ในคีย์โน้ตของ Apple พูดถึงอุปกรณ์ที่รองรับ Apple Intelligence โดยอิงจาก ‘ชิป’ เป็นเกณฑ์ มีเกณฑ์ขั้นต่ำตามที่ระบุคือ A17 Pro สำหรับ iPhone และ M1 สำหรับ iPad และสินค้ากลุ่ม Mac

พอเห็นแบบนี้ คงไม่แปลกนักหากใครสักคน (หรือหลายคน) จะพาลเข้าใจไปว่า Neural Engine บน A16 Bionic ของ iPhone 15 นั้นแรงไม่พอจะขับเคลื่อนโมเดล AI จนกลายเป็นคอขวด ซึ่ง A16 Bionic สามารถประมวลผล AI ได้ 17 TOPS ส่วน A17 Pro ของ iPhone 15 Pro กระโดดไป 35 TOPS เป็นตัวเลขที่ห่างกันเกิน 2 เท่า ก็โอเค… ดูเป็นเหตุผลที่พอเข้าเค้าอยู่บ้าง

| Neural Engine | RAM | ||

| (แกน) | (ประสิทธิภาพ) | ||

| A17 Pro | 16-core | 35 TOPS | 8GB |

| A16 Bionic | 17 TOPS | 6GB | |

| A15 Bionic | 15.8 TOPS | 4 – 6GB | |

| M1 | 11 TOPS | 8GB+ | |

แต่คำตอบนี้จะโดนตีตกไปทันที เมื่อหันไปดู M1 ที่ประมวลผล AI ได้ 11 TOPS น้อยกว่า A16 Bionic ซะอีก หรือย้อนกลับไปอีกถึง A15 Bionic รุ่นก่อนหน้านั้น ก็ทำได้ 15.8 TOPS ยังชนะ M1 ใส ๆ อยู่ดี สิ่งนี้จึงเป็นหลักฐานชิ้นโตที่บ่งบอกอย่างชัดเจนว่า ข้อจำกัดของการรองรับ Apple Intelligenceไม่ได้มาจาก Neural Engine บน A16 Bionic แต่อย่างใด

คำตอบอาจอยู่ที่ RAM

เมื่อ ‘ชิป’ ไม่ใช่คำตอบ แล้วคำตอบคืออะไร ?

…คำตอบคือ RAM หรือ ‘หน่วยความจำ’ ซึ่ง iPhone 15 และ iPhone 15 Pro เป็นเพียงมือถือ 2 รุ่นเท่านั้นที่ Apple ให้ RAM มา 8GB รุ่นอื่นที่ต่ำลงไปกว่านี้ได้ 6GB หรือ 4GB ขึ้นอยู่กับรุ่น

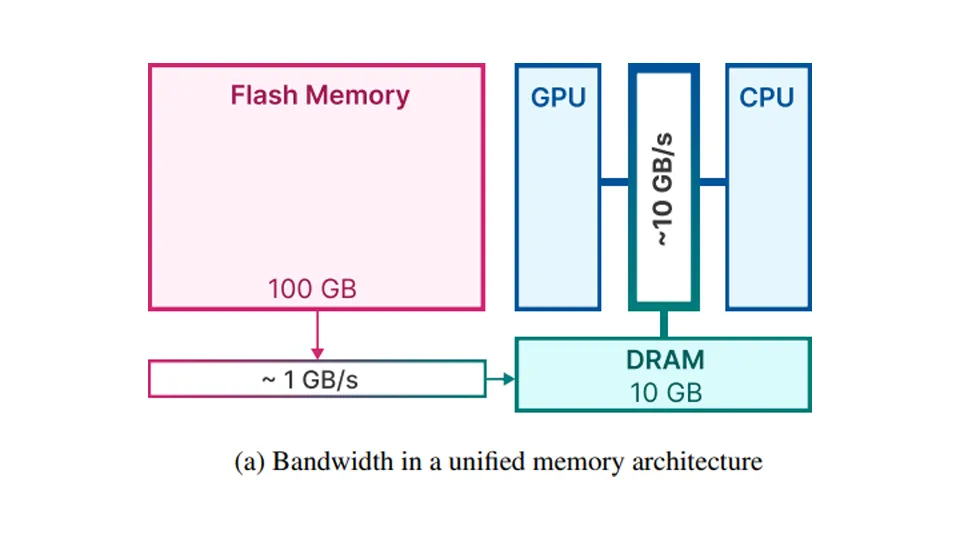

RAM ถือเป็นปัจจัยสำคัญในการรัน AI แบบ on-device บนตัวอุปกรณ์ ปกติแล้ว LLM จะใช้พื้นที่ใน RAM ประมาณ 2GB± ตลอดเวลา สำหรับเคสทั่ว ๆ ไป

ส่วนกรณี Apple Intelligence เป็นโมเดลขนาด 3B ที่ถึงแม้ Apple จะพยายามออกแบบเฟรมเวิร์กใหม่ จากการผสมคอนฟิก 2-bit กับ 4-bit เข้าด้วยกัน จน Apple Intelligence ต้องการ RAM น้องลง เหลือแค่ราว ๆ 0.7 ~ 1.5GB แต่ก็ยังมากเกินกว่าที่ RAM ขนาด 6GB ของ iPhone 15 และรุ่นต่ำกว่าจะแบกไหวอยู่ดี (ยังไม่นับว่าในอนาคตอาจมีการขยายขนาดโมเดลเพิ่มอีกเมื่อไปถึงจุดจุดหนึ่ง เพื่อให้รองรับการสั่งงานที่ซับซ้อนมากขึ้น ใส่ฟีเจอร์ใหม่ ๆ เข้าไปได้มากขึ้น)

ในอนาคตจะมีหวังมั้ย ?

Apple ไม่ใช่ค่ายเดียวที่ติดปัญหาคอขวดเรื่อง RAM ก่อนหน้านี้ Google เองก็กั๊ก Gemini Nano ให้เฉพาะ Pixel 8 Pro ตัวท็อปด้วยข้อจำกัดเรื่อง RAM เหมือนกัน ก่อนจะปลดล็อกให้ Pixel 8 ไปเมื่อไม่กี่วันก่อน ทำให้มีการคาดการณ์กันว่า Google อาจหาวิธีลดการกินทรัพยากรของ LLM ได้แล้ว ดังนั้น หากจะหวังให้ iPhone 15 สามารถรัน Apple Intelligence ได้ ก็คงต้องหวังให้ Apple ทำแบบเดียวกับ Google ได้ก่อน หรือไม่ก็ใช้เทคนิคอื่นที่ให้ผลลัพธ์ปลายทางในลักษณะเดียวกัน (ซึ่งยังไม่รู้ว่าคืออะไร)

ถึงกระนั้น Google กับ Apple ก็มีข้อแตกต่างสำคัญอยู่หนึ่งประการ คือ Pixel 8 มี RAM 8GB ไม่เหมือน iPhone 15 ที่มี RAM 6GB ความยากง่ายย่อมต่างกันอย่างมีนัยสำคัญแน่นอน

ข่าวดีเล็ก ๆ คือ มีหลักฐานว่า Apple วิจัยเรื่องการลดการใช้ RAM ของโมเดล AI มาได้ระยะหนึ่งแล้ว หรือไม่แน่ว่าสุดท้ายนี่อาจเป็นคำตอบของอนาคตของ Apple ในการนำ Apple Intelligence มารันบน iPhone รุ่นอื่น ๆ ที่เหลือก็เป็นได้

เหมือนเป็นการเตะตัดขาตัวเอง ด้วยข้อจำกัดทางเทคนิคไปกลาย ๆ แบบนี้ยอดขายรุ่นต่ำกว่า Pro และ Pro Max จะลดลงเยอะไหมหนอ

ดู ๆ แล้ว เขาน่าจะขี้เกียจต่อยอดพวกรุ่นเก่าแหละ ไม่น่าเกี่ยวกับ Pro ไม่ Pro

iPhone 15 กับ iPhone 15 Plus ก้อไม่ได้น่ะครับ แถวเป็นรุ่นใหม่ล่าสุดแล้วด้วย ก้อยังไม่ได้

เข้าใจค้าบว่ามันมาปีที่แล้ว แต่แอปเปิลคงมองว่าพวกตระกูล Bionic คือเก่าไปแล้วมั้งครับ (ผมก็เดาล้วน ๆ) ก็คือหาเรื่องกั๊กนั่นละค้าบ หรือถ้าจะเน้นแต่ Pro ก็น่าเกลียดจริง ๆ เพราะฟีเจอร์มันไม่ได้ "โปร" อะไรมากเล้ย

ผมมาจากอนาคต ลงท้าย แรมเยอะแรมน้อย ปีครึ่งผ่านมา (จาก กลางปี 67 ตอนนี้ เดือน 2 ปี 69 แล้ว) ก็ยังไม่ได้ใช้ครับ