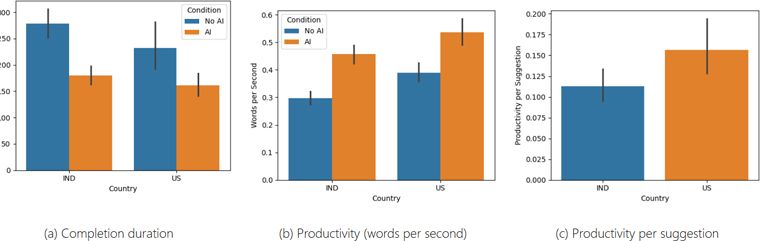

นักวิจัยจากมหาวิทยาลัยคอร์เนลล์ ในสหรัฐฯ ทำการศึกษาเกี่ยวกับการนำเครื่องมือ AI มาช่วยเขียนบทความที่เนื้อหาที่เกี่ยวข้องกับวัฒนธรรมในภาษาอังกฤษ จากกลุ่มผู้ทดสอบ 118 คน แบ่งเป็นชาวอินเดีย 60 คน และชาวอเมริกัน 58 คน ผลที่ได้คือการค้นพบว่า AI มีความลำเอียง ทั้งในแง่ของวัฒนธรรมที่มักนำเสนอหรือให้คำแนะนำตามค่านิยมแบบตะวันตก และสไตล์การเขียนที่เอนเอียงไปทางชาวอเมริกัน

เป็นต้นว่า หากป้อนคำสั่งเกี่ยวกับ ‘อาหาร’ และ ‘วันหยุด’ เครื่องมือ AI มักให้คำแนะนำหรือเขียนบทความออกมาเป็นหัวข้อเกี่ยวกับ ‘พิซซ่า’ และ ‘วันคริสต์มาส’ ตามลำดับ

ความลำเอียงดังกล่าว ส่งผลให้คนชาติอื่นสามารถใช้ประโยชน์จากเครื่องมือ AI ช่วยเขียนบทความได้น้อยกว่าชาวตะวันตก จากที่ควรจะเป็นเครื่องมือช่วยทุ่นเวลา บางครั้งผลลัพธ์อาจออกมาตรงข้ามกัน หากต้องมีการแก้ไขเนื้อหาในหลายจุดหรือป้อนคำสั่งใหม่

นอกจากนี้ นักวิจัยยังได้ชี้ให้เห็นถึงข้อกังวลในแง่การกลืนกินทางด้านวัฒนธรรม ซึ่งอาจนำไปสู่ความรู้สึกด้อยค่าหรือสูญเสียอัตลักษณ์ทางวัฒนธรรมในระยะยาว

นักวิจัยได้ให้ข้อเสนอแนะว่า ผู้พัฒนาควรฝึกโมเดล AI โดยคำนึงถึงความหลากหลายทางวัฒนธรรม มากกว่าจะมุ่งเน้นไปที่ด้านภาษาเพียงอย่างเดียว

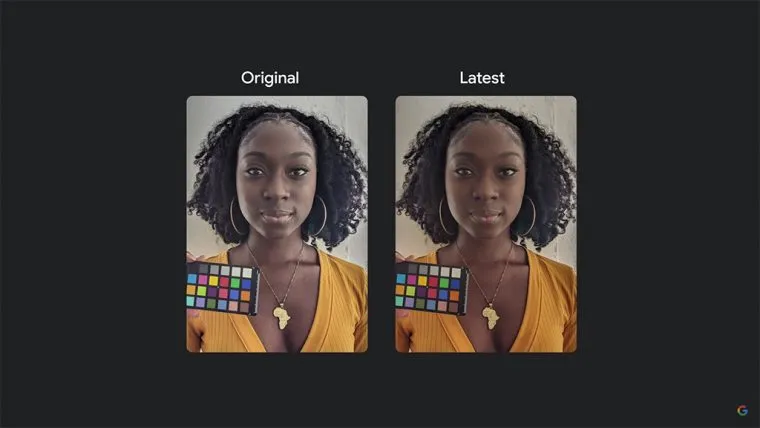

ประเด็นเกี่ยวกับความลำเอียงของ AI ไม่ใช่ประเด็นใหม่ หลายปีก่อน กูเกิลเองก็เคยพูดถึงความลำเอียงของ AI กับการปรับโทนสีผิวมนุษย์ ซึ่งโมเดลส่วนใหญ่ในขณะนั้นมักถูกเทรนด้วยภาพถ่ายของบุคคลที่มีผิวขาว สีของภาพจึงมักออกมาเพี้ยนเมื่อถ่ายคนผิวเข้ม และสิ่งนี้ก็เป็นที่มาของฟีเจอร์ Real Tone บนมือถือ Pixel ที่พัฒนาต่อเนื่องมาจนถึงปัจจุบัน

ที่มา Cornell University

Comment