Facebook ต้องออกมาแถลงขอโทษจากเหตุการที่ระบบ AI เกิดข้อผิดพลาดจากการสแกนเพื่อจำแนกภาพในคลิปวิดีโอข่าวที่เกี่ยวกับชายผิวดำ แต่ระบบ AI กลับคิดว่าวิดีโอนั้นเป็นวิดีโอเกี่ยวกับ Primate หรือ ลิง ซึ่งหลังจากมีผู้ใช้งานค้นพบข้อผิดพลาดของระบบ AI ดังกล่าวแล้ว ทาง Facebook จึงออกมาขอโทษและบอกว่ามันเป็น “ข้อผิดพลาดที่ไม่สามารถยอมรับได้” และจะตรวจสอบระบบเพื่อไม่ให้เกิดขึ้นอีกครั้ง

เหตุการณ์นี้เกิดขึ้นจากการที่มีผู้ใช้งานแอป Facebook ไถหน้า Feed ไปเจอกับข่าวของเพจ Daily Mail ที่โพสต์ไว้เมื่อวันที่ 27 มิถุนายน 2563 โดยเป็นข่าวนั้นเป็นคลิปวิดีโอที่มีชื่อว่า “White man calls cops on black men at marina” (ชายผิวขาวเรียกตำรวจมาจับชายผิวดำที่ท่าจอดเรือ) และด้านล่างของคลิปก็มีแถบแนะนำวิดีโอ (Label) เพื่อถามผู้ใช้งานว่า “Keep seeing videos about Primates?” (ต้องการดูวิดีโอเกี่ยวกับลิงอีกหรือไม่?) จากนั้นก็แคปหน้าจอเอาไว้แล้วส่งมาให้ Facebook ดูอีกที

หลังจากที่ Facebook รับรู้ถึงข้อผิดพลาดในการทำงานของระบบ AI ตามข่าว ก็เลยรีบออกมาตรวจสอบหาความจริงว่าอะไรทำให้มันผิดพลาดไปได้ขนาดนี้ และได้หยุดการทำงานของฟีเจอร์จำแนกประเภทของภาพ/วิดีโอเพื่อแนะนำคอนเท้นต์ในทันที

โดยเมื่อวันศุกร์ที่ 3 กันยายน 2564 ทาง Facebook ก็ได้ออกมาแถลงการณ์ขอโทษสำหรับข้อผิดพลาดของระบบ AI และได้บอกว่ามันเป็น ข้อผิดพลาดที่ไม่สามารถยอมรับได้ ซึ่งทางบริษัทจะดำเนินการหาจุดบกพร่องของฟีเจอร์นี้เพื่อป้องกันไม่ให้มันเกิดขึ้นอีกรอบ และจะปรับปรุงพัฒนาระบบ AI ต่อไป

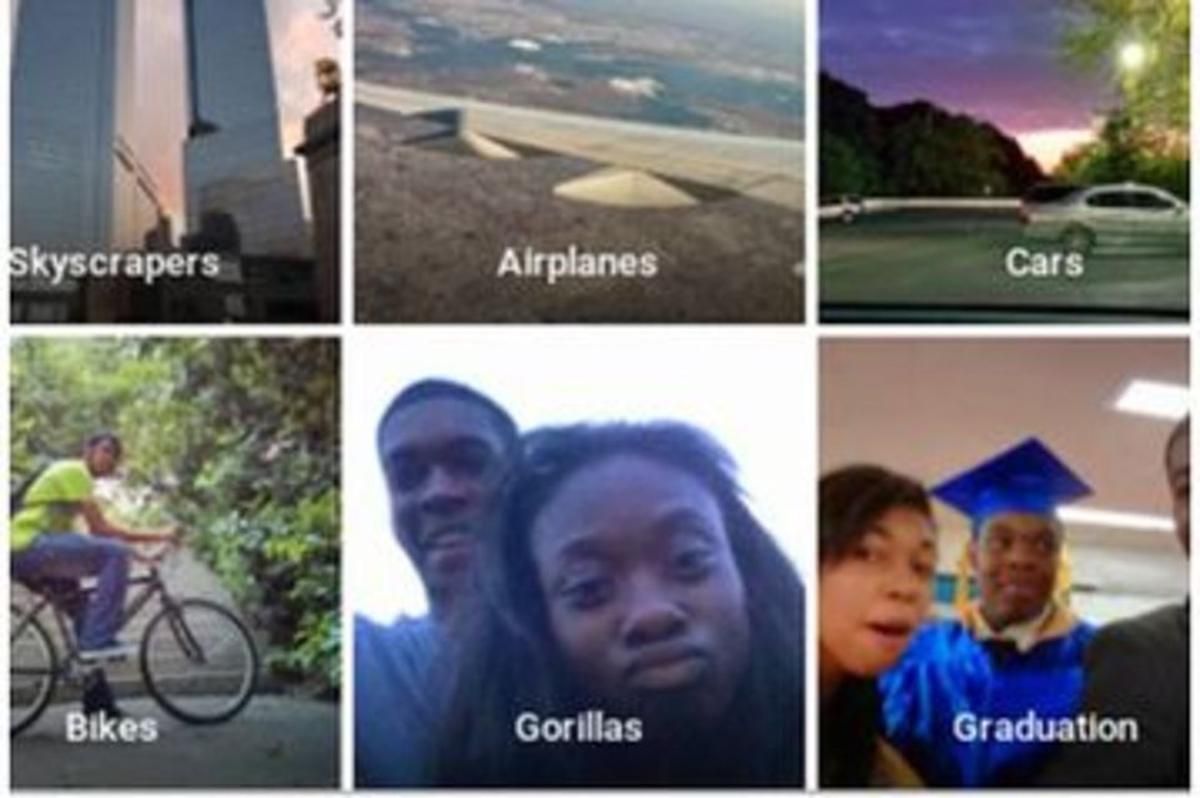

จริง ๆ แล้วนี่ไม่ใช่ครั้งแรกที่ระบบ AI ที่ใช้ในการจำแนกใบหน้าเกิดความผิดพลาดขึ้นกับเหล่าคนผิวสี อย่างเมื่อปี 2558 ระบบ AI ของ Google Photos ก็เคยแปะ Label ผิดเช่นกัน โดยระบุว่ารูปของคนผิวดำเป็นกอริลล่า จนกลายเป็นเรื่องเป็นราวเกี่ยวกับการเหยียดผิวมาแล้ว ซึ่งหลังจากนั้น Google ก็ต้องออกมาแถลงการณ์ขอโทษเช่นกัน และแก้ปัญหาด้วยการตัดคำว่า กอริลล่า, ชิมแปนซี และลิง ออกไปจากระบบการค้นหาใบหน้าของแอปซะเลย

ที่มา : npr

ดูๆไปมันก็มีส่วนคล้ายเหมือนกันอะนะ เพราะผมกระเซิงซะขนาดนั้น ยิ่งลิงมีแต่สีดำ คนดำเลยดูแล้วคล้าย