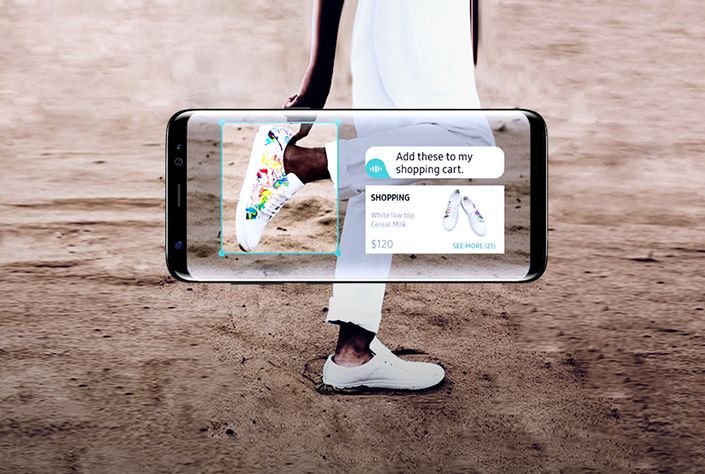

เมื่อวันที่ 4 ตุลาคมที่ผ่านมาในงานเปิดตัว Pixel 2 / XL เราก็ได้เห็นประสิทธิภาพของ AI สุดล้ำที่อยู่ในฟีเจอร์ Google Lens ที่ติดมากับ Pixel 2 / XL โดยฟีเจอร์ดังกล่าวสามารถวิเคราะห์ภาพถ่ายได้ทั้งจากกล้อง หรือภาพที่อยู่ในตัวเครื่องได้ เช่นถ่ายภาพรองเท้า Google Lens ก็จะหาภาพ, ข้อมูล, ราคาของรองเท้าที่คล้ายๆกันขึ้นมาให้เราดู และตอนนี้ Google ก็ปล่อยฟีเจอร์นี้ให้กับ Pixel รุ่นปีที่แล้วได้ลองใช้กันแล้วด้วย

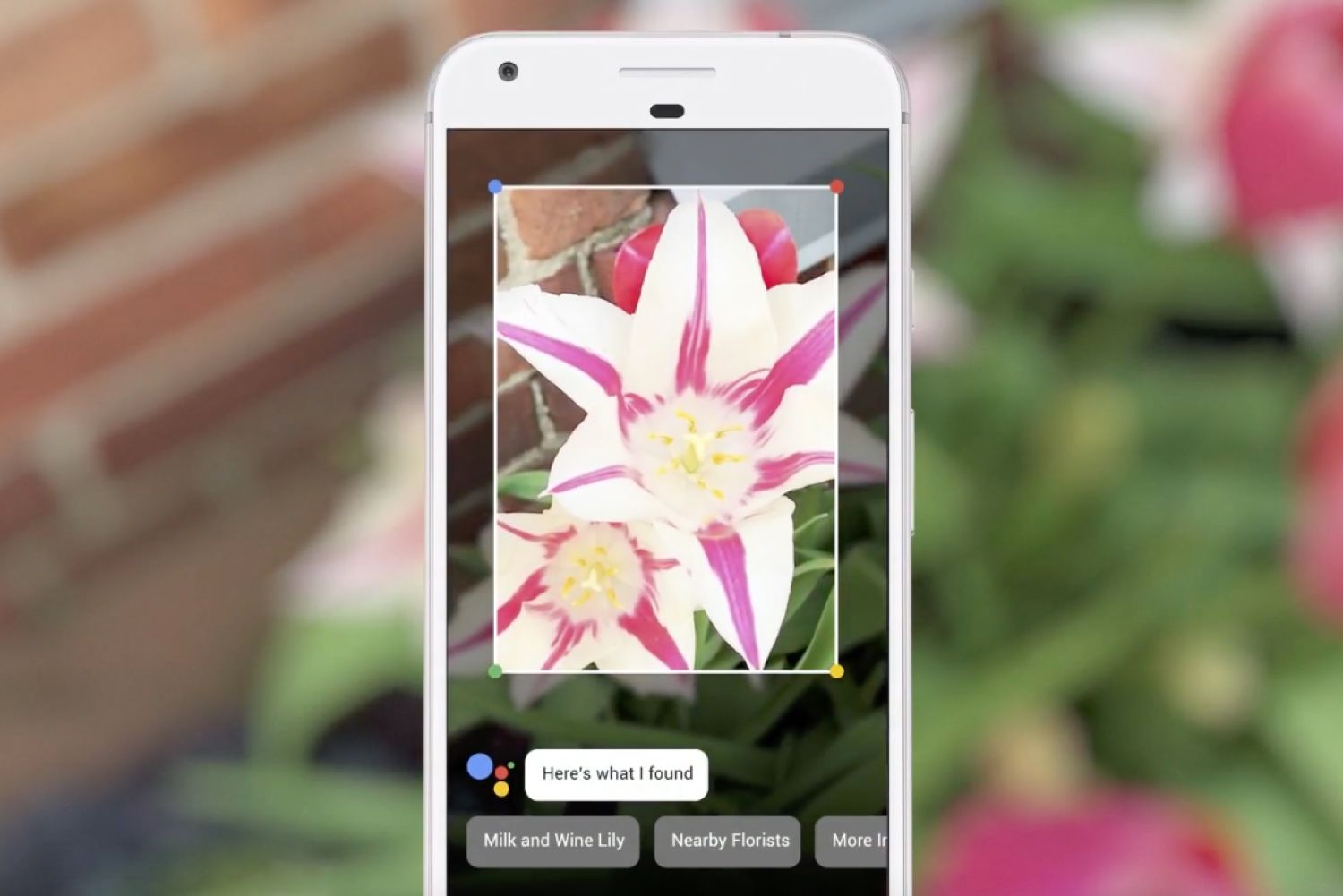

Google Lens คือฟีเจอร์ที่จะใช้ระบบ AI ในการช่วยวิเคราะห์ภาพที่เราต้องการ ไม่ว่าจะเป็นภาพสถานที่ท่องเที่ยว ภาพสินค้า หรือแม้แต่เมนูอาหารที่เป็นภาษาต่างประเทศ จากนั้น Google Lens ก็จะแสดงข้อมูลของภาพเหล่านั้นออกมา เช่นเราถ่ายภาพของวัดพระแก้ว Google Lens ก็จะวิเคราะห์ภาพที่เราถ่าย และหลังจากรู้ว่าภาพนั้นคืออะไร ก็จะโชว์ข้อมูลของวัดพระแก้วขึ้นมา หรือเรายกมือถือขึ้นมาถ่ายภาพร้านอาหาร Google Lens ก็จะโชว์ข้อมูล และรีวิวต่างๆของร้านนั้นขึ้นมาให้ ซึ่งการทำงานของ Google Lens ก็จะคล้ายๆกับ Bixby Vision ในมือถือเรือธงทางฝั่ง Samsung นั่นเอง

ในตอนแรก Google Lens จะมีให้ใช้แค่ในมือถือรุ่นล่าสุดที่พึ่งเปิดตัวไป อย่าง Pixel 2 / XL เท่านั้น แต่ในตอนนี้ Google ได้ปล่อยอัพเดทให้ Pixel / XL รุ่นปีที่แล้วได้ลองใช้ฟีเจอร์นี้กันบ้าง แต่ฟีเจอร์ Google Lens จะซ่อนอยู่ในแอป Google Photos นั่นเอง ถ้าเครื่องไหนที่ได้รับการอัพเดทแล้ว เมื่อเปิดแอป Google Photos เข้ามา ก็จะเจอกับหน้าแนะนำ Google Lens และหลังจากกด Get Started ก็สามารถเริ่มใช้งาน Google Lens กันได้เลย

![]()

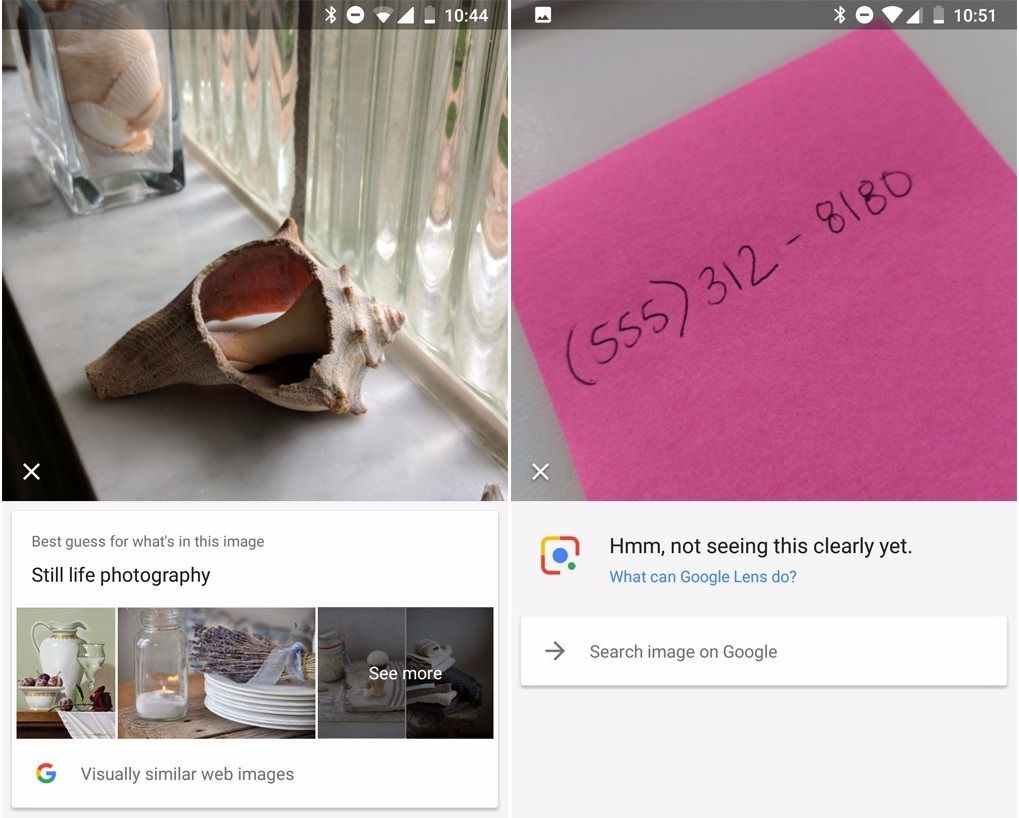

แต่หลังจากที่มีคนเริ่มใช้งาน Google Lens บ้างแล้ว (ใน Pixel 2) ก็พบว่าการวิเคราะห์ภาพถ่าย บางทีก็ไม่ค่อยแม่นเอาซะเลย ซึ่งก็ต้องรอให้เจ้า Google Lens ได้เรียนรู้และพัฒนาต่อไปเรื่อยๆ ถึงจะวิเคราะห์ได้แม่นกว่านี้

(ซ้าย) ถ่ายรูปเปลือกหอยดันวิเคราะห์ว่าเป็นเครื่องครัว (ขวา) อ่านลายมือยังไม่ออก

แต่น่าเสียดายที่ตอนนี้ยังไม่มีข้อมูลเลยว่า Google จะปล่อยฟีเจอร์ Google Lens ให้กับมือถือ Android รุ่นอื่นๆรึเปล่า หรือจะกั๊กเอาไว้ใช้กับ Pixel เท่านั้น (เหมือน Bixby ที่มีเฉพาะใน Samsung) เอาไว้ถ้าเราได้ข้อมูลเพิ่มเติมแล้วจะมาบอกนะครับ

ที่มา : 9to5google, Businessinsider

Comment