ลองนึกกันเล่นๆ สิว่าหากโลกนี้มีเทคโนโลยีที่สามารถดึงรูปใน Facebook, Instagram หรือในโซเชีลมีเดียอื่นๆ ของเราเพียงแค่ไม่กี่รูป หรือรูปเดียว แล้วสามารถนำไปเปลี่ยนตัดต่อให้เป็นคลิปวิดีโอบางสิ่งบางอย่างที่เราไม่เคยทำหรือคิดที่จะทำ จะเกิดอะไรขึ้น? ล่าสุด Samsung กำลังนำเทคโนโลยีดังกล่าวมาพัฒนาสามารถเปลี่ยนภาพโมนาลิซาที่มีอากัปกิริยาเพียงท่าเดียว ให้เป็นคลิปวิดีโอสั้นๆ ได้ และที่สำคัญคุณภาพของคลิปก็เหมือนกับถ่ายตอนที่เธอกำลังพูดอยู่จริงๆ ด้วย ทั้งท่าทางการขยับหัวหรือกระพริบตา

เราจะเชื่ออะไรได้อีก!! เทคโนโลยีใหม่สามารถแปลงภาพนิ่งของบุคคล ให้สามารถขยับเหมือนพูดอยู่ได้ นี่ภาพโมนาลิซ่าที่เราเห็นมาตลอดชีวิต ไม่เคยคิดว่าจะเห็นนางขยับได้แบบมีชีวิตขนาดนี้นะเนี่ย โดยเทคโนโลยีนี้ชื่อ deepfake AI จาก Samsung // แค่คิดว่ามันหลุดมาใช้ในชีวิตจริงก็สยองแล้ว 😱😱😱 pic.twitter.com/CBQYP1JNAI

— droidsans (@droidsans) May 24, 2019

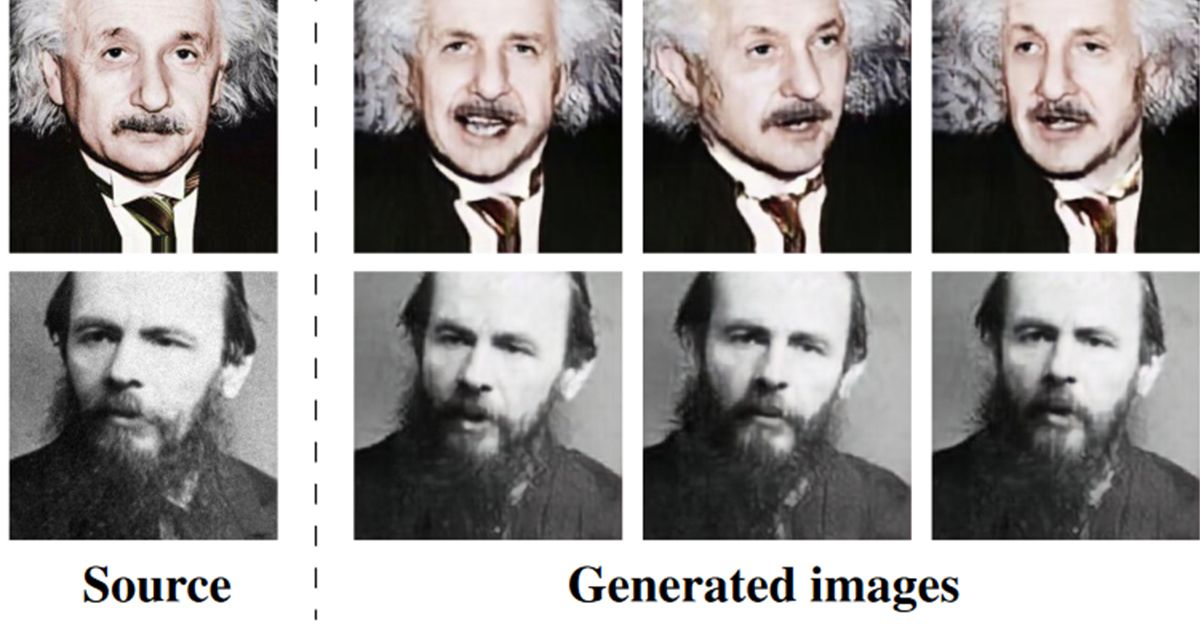

เดิมทีการจะทำ deepfake (เทคโนโลยีที่สร้างคลิปของบุคคลคนหนึ่งโดยที่คนนั้นไม่จำเป็นต้องทำกิจกรรมดังกล่าวมาก่อน) ให้เหมือนจริง จะต้องพึ่งพาฐานข้อมูลรูปภาพที่เยอะมาก ซึ่งในอดีตเราอาจจะเคยได้เห็นเหล่าดาราหรือคนดังตกเป็นเหยื่อให้กับเทคโนโลยีตัวนี้มาแล้วบ้าง เนื่องจากบนอินเตอร์เน็ตนั้นมีรูปภาพของพวกเขาอยู่เยอะและมีให้เลือกอย่างหลากหลาย ทำให้เป็นเรื่องง่ายต่อผู้ที่ไม่หวังดี ที่จะสร้างคลิปนั้นขึ้นมาเพื่อความบันเทิงหรือด้วยเหตุผลอะไรก็ตามแต่ แต่แล้ววันนี้ดูเหมือนว่าคนปกติเองอย่างพวกเราก็จะเริ่มไม่ปลอดภัยเสียแล้ว เนื่องจาก Samsung ดันคิดค้นวิธีสร้างคลิป deepfake ขึ้นมา โดยจะอาศัยเพียงแค่รูปหน้าตรงเพียงรูปเดียวเท่านั้น! และหากว่ามีภาพยิ่งเยอะ หรือวิดีโอให้เห็นได้แบบเต็มๆหัวเลยก็แยกกันไม่ออกแล้วอันไหนจริงอันไหนปลอม

แต่แน่นอนแหละ จุดประสงค์ของการพัฒนาเทคโนโลยีดังกล่าวขึ้นมาของ Samsung มีไว้เพื่อสำหรับประโยชน์ในแง่ของการประชุมหรืออาจจะนำไปใช้ประโยชน์ได้ในแวดวง special effects เป็นอย่างมาก หรือแม้กระทั่งสำหรับความสนุกสนานก็ยังได้! อย่างเช่นที่ยกตัวอย่างไปข้างต้น ที่จะนำภาพวาดสุดคลาสสิคอย่างโมนาลิซามาทำเป็นภาพเคลื่อนไหว แต่แล้วก็อย่างที่หลายคนเป็นห่วงกัน ข้อเสียของมันกลับใหญ่หลวงนี่สิ! ก็คือหากมีบุคคลไม่หวังดีหรือคิดมิดีมิร้ายกับเราเมื่อไหร่ พวกเขาสามารถนำรูปภาพของเราไปใช้ในทางที่ผิดเพื่อเรียกค่าไถ่หรือทำให้เราเสื่อมเสียชื่อเสียงได้เลย

อย่างไรก็ดี เทคโนโลยีที่ว่าก็ยังอยู่ในขั้นเริ่มต้นอยู่มากๆ ผลลัพธ์ที่ได้อาจจะยังดูไม่สมจริงอยู่ แต่สำหรับในอนาคตแล้วคงปฏิเสธไม่ได้เลยว่ามันอาจจะมีประสิทธิภาพมากขึ้น แล้วก็ไม่อยากนึกภาพเลยล่ะว่าจะเกิดอะไรขึ้นหากมันตกไปอยู่ในมือคนไม่ดี.. คิดค้นอะไรแบบนี้มาได้แล้ว ก็เก็บๆเอาไว้ในแล็บอย่าให้หลุดออกมาใช้ผิดที่ผิดทางน่อ

via: phonearena & cnet

ต่อไปหลักฐานวีดีโอ ใช้เป็นพยานในศาลไม่ได้อีกแล้ว

ผมว่ายังได้อยู่นะครับ แต่ก็ต้องมีผู้เชี่ยวชาญมาตรวจว่าคลิปจริงหรือเปล่า พวกทำกราฟิคคงดูออกแหละครับ

เดียวนี้ เทคโนโลยีต่าง ๆๆ ชักไปไกล แหละ 🙂 🙂

🙂 🙂

โหลดได้ที่ไหนครับ

คิดในแง่กลับกัน พวกที่คลิปหลุดก็แถยืนกรานไปเลยว่าเป็นคลิปปลอม เพราะมันเหมือนมากๆ อยู่แล้ว แต่ถ้าครางชื่อออกมาช่วยไม่ได้นะ