เก็บตกงาน Google I/O กันอีกสักเล็กน้อย Google พึ่งออกฟีเจอร์ Multisearch ให้แก่ Google Lens ไปเมื่อ 5 สัปดาห์ก่อน เป็นฟีเจอร์ค้นหาแบบซับซ้อนด้วยภาพและข้อความ ล่าสุดมีการประกาศอัปเกรดความสามารถเพิ่มเติม กลายเป็น Multisearch near me พร้อมเพิ่มฟีเจอร์ใหม่ Scene exploration ค้นหาข้อมูลเชิงลึกของสิ่งของหลายชิ้นพร้อมกันได้ในคราวเดียว

Multisearch near me – ค้นหาอะไรก็เจอ แถมรู้ว่าร้านไหนมีขาย

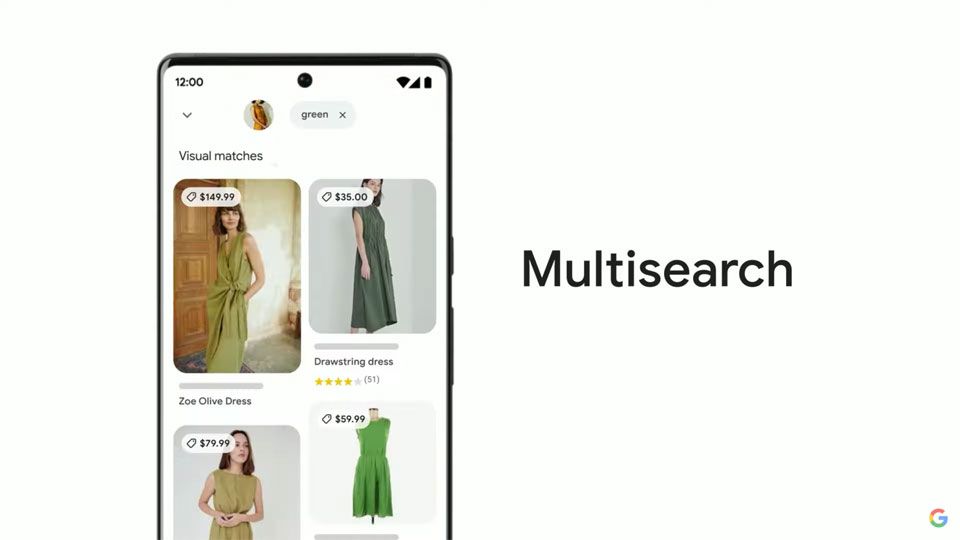

ตามที่เคยนำเสนอไปก่อนหน้านี้ Multisearch เป็นการค้นหาด้วยรูปภาพผ่าน Google Lens โดยที่ผู้ใช้งานสามารถพิมพ์ข้อความเสริมเข้าไปภายหลัง เพื่อเพิ่มเงื่อนไขในการค้นหานั้น ๆ เช่น ถ่ายรูปเสื้อมาหนึ่งตัว เราอาจถูกใจเสื้อแบบนี้ แต่อยากได้เป็นสีอื่น ก็แค่พิมพ์ว่า “สีเขียว” ระบบก็จะไปทำการค้นหาเสื้อแบบเดียวกัน หรือที่มีลักษณะใกล้เคียงกัน แต่เป็นสีเขียว มาแสดงให้เราดู

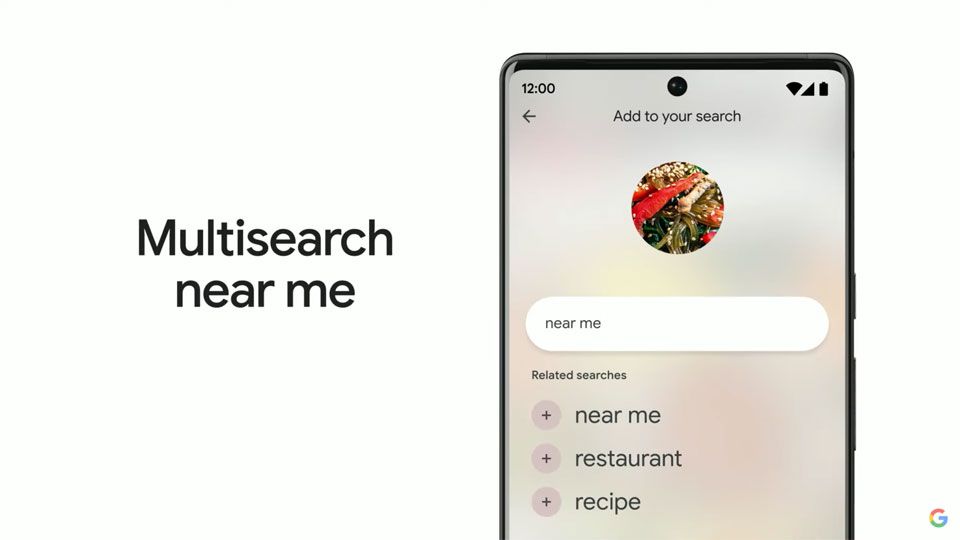

ในขณะที่ Multisearch near me จะเพิ่มผลลัพธ์ของร้านค้าหรือร้านอาหารที่อยู่ใกล้เคียงเข้ามา ยกตัวอย่างต่อเนื่องจากด้านบน พอเราหาเสื้อสีเขียวในแบบที่อยากได้เจอแล้ว พิมพ์ว่า “near me” เข้าไป Google ก็ไปจะไปดึงข้อมูลจาก Google Maps มาโชว์ให้ดูเลยว่า แถวบ้านเราร้านไหนมีขายบ้าง ถูกใจนักช็อปและนักกินแน่นอน

Scene exploration – ค้นหาผ่านกล้องพร้อมกำหนดเงื่อนไขแบบเรียลไทม์

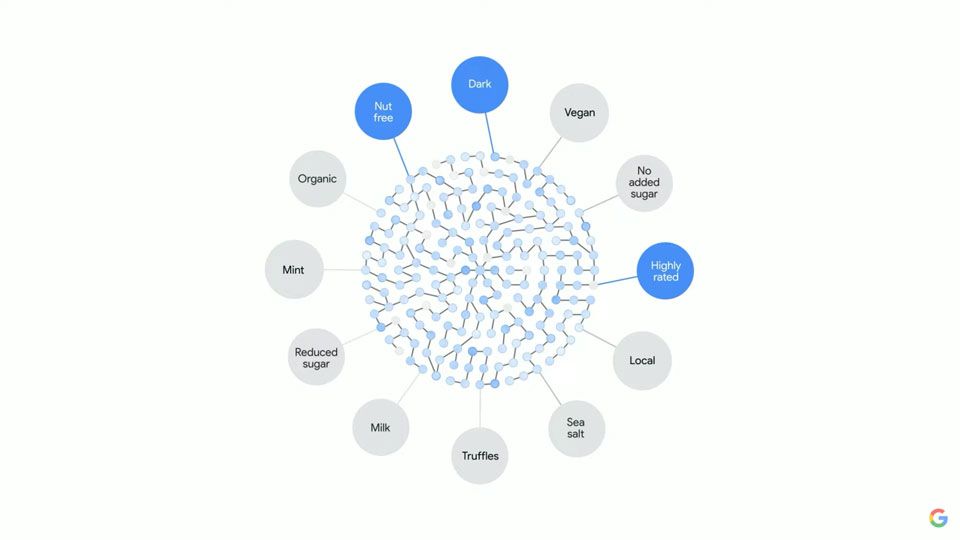

เดิมที การค้นหาของ Google Lens ในแต่ละครั้งจะถูกจำกัดเอาไว้เฉพาะวัตถุที่อยู่ในเฟรมเดียวกัน แต่พออัปเกรดเป็น Scene exploration แล้ว คราวนี้เราสามารถใช้งานฟีเจอร์ Multisearch เพื่อสร้างเงื่อนไขในการค้นหาขณะแพนกล้องไปรอบ ๆ ได้ ซึ่งแน่นอนว่า…มันทำงานแบบเรียลไทม์ ขึ้นผลการค้นหาให้ดู ณ เดี๋ยวนั้นแบบสด ๆ เลย (โหดมาก คนในงานลุกขึ้นตบมือเกรียวกราว)

ตัวอย่างการใช้งานที่ Google นำเสนอให้ชมกันในงานคือ เพื่อนฝากเราซื้อช็อกโกแลตในซูเปอร์มาร์เกต พร้อมกับเงื่อนไขว่า ต้องเป็นดาร์กช็อกโกแลต ที่ไม่มีถั่วเป็นส่วนผสม และอร่อย (อ้างอิงจากคะแนนรีวิวสินค้าในฐานข้อมูล) รวมเป็น 3 เงื่อนไข

พอใส่ป้อนเงื่อนไขใส่ Google Lens ครบทั้งหมดแล้ว เราก็แค่แพนไปตามเชลฟ์ที่มีช็อกโกแลตยี่ห้อต่าง ๆ วางอยู่เรียงราย อันไหนที่มันตรงกับเงื่อนไขก็จะปรากฏเป็นไฮไลต์เด่น ๆ ขึ้นมาบนภาพ อะไรทำนองนี้เป็นต้น ฟีเจอร์นี้เป็นสิ่งที่แสดงให้เห็นเลยว่า AI ของ Google ฉลาดขนาดไหน เปรียบเสมือนกับมีฟังก์ชัน Ctrl + F ของ Chrome ในโลกจริงก็ไม่ปาน

อีกหนึ่งประเด็นน่าสนใจคือ Google บอกว่า ปีที่แล้วยอดการค้นหาผ่าน Google Lens เติบโตขึ้นถึง 3 เท่า โดยเฉลี่ยแล้วแต่ละเดือนมันถูกใช้งานกว่า 8 พันล้านครั้งทั่วโลกเลยทีเดียว

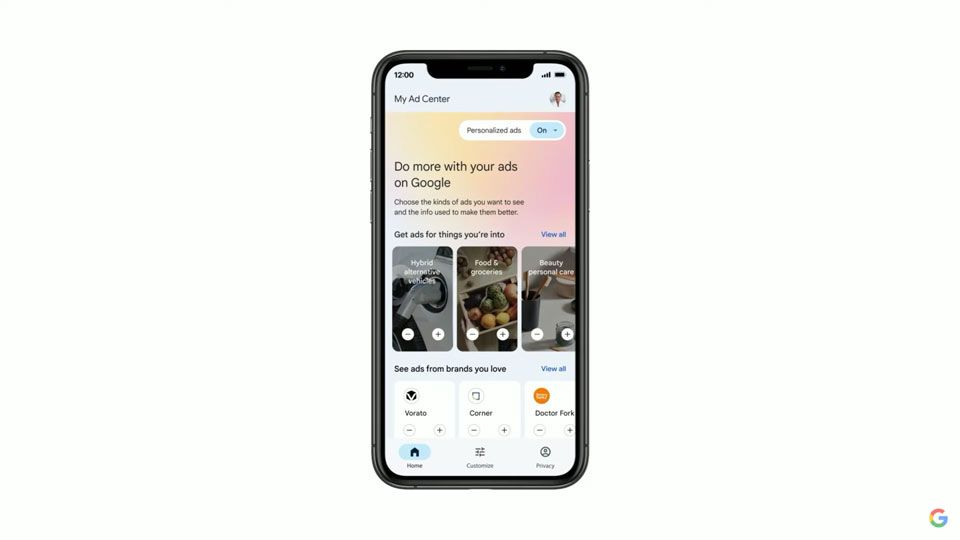

My Ad Center – ควบคุมเนื้อหาโฆษณาได้ด้วยตนเอง

เราทุกคนต่างทราบกันดีว่า รายได้หลักของ Alphabet บริษัทแม่ Google มีที่มาจากธุรกิจโฆษณา คิดเป็นสัดส่วนกว่า 80% ของรายได้ทั้งหมด ซึ่งต้องอาศัยการเก็บรวมรวมข้อมูลและพฤติกรรมการใช้งานของลูกค้า จนมีมุกแซวกันอยู่บ่อย ๆ ว่า “Google อาจรู้จักตัวตนของเรา ดีกว่าที่เรารู้จักตัวเองเสียอีก” (ฮา)

แต่ทั้งนี้ ทาง Google ก็แสดงความบริสุทธิ์ใจ โดยบอกว่า ถึงเราจะหากินกับโฆษณาก็จริง แต่ก็โปร่งใส ตรวจสอบได้ และไม่เคยเอาข้อมูลไปขายให้กับบริษัทอื่น และสิ่งที่ Google กำลังจะทำต่อไปคือ My Ad Center ให้ผู้ใช้งานควบคุมเนื้อหาโฆษณาได้ด้วยต้นเอง

My Ad Center จะแบ่งสิ่งต่าง ๆ ที่เราสนใจออกเป็นหมวดหมู่ เนื้อหาอะไรที่เราไม่ชอบ หรือไม่อยากให้โผล่มาอยู่บนฟีด เช่น เนื้อหาเกี่ยวกับการพนันหรือสิ่งลามก ก็แค่ปิดมันซะจากในนี้ โดยจะมีผลทั้ง YouTube, Search, Discover และแพลตฟอร์มที่ใช้บริการโฆษณาจาก Google หรือในทางตรงกันข้าม เนื้อหาไหนที่เราชอบมากเป็นพิเศษ อยากให้โผล่มาบนฟีดบ่อย ๆ ก็กำหนดด้วยตัวเองได้เช่นกัน

Multisearch near me เบื้องต้นจะรองรับเฉพาะภาษาอังกฤษ ส่วนภาษาอื่น ๆ จะทยอยตามมาในอนาคต ส่วนกำหนดการเปิดให้บริการ Google ระบุกว้าง ๆ เป็นในช่วงปลายปีนี้ เช่นเดียวกับ My Ad Center

ที่มา : Google I/O

My Ad Center มองว่าเป็นการช่วย Google ยิง Ads ได้แม่นยำขึ้นมากกว่า