นอกจากเราจะมีเครื่องมือจาก Google ในการแปลภาษาต่างประเทศได้หลากหลายรูปแบบ ไม่ว่าจะเป็นการพิมพ์ใส่มือถือเพื่อหาคำแปล, การใช้กล้องส่องไปที่ป้ายภาษาต่างๆ เพื่อหาคำแปล หรือแม้แต่การแปลภาษาจากคำพูดได้แบบ Real-time แล้ว ในอนาคตเรายังจะสามารถแปลภาษามือที่มักจะใช้กันในกลุ่มผู้พิการทางหูได้แบบ Real-time อีกด้วย

ในตอนแรก Google ได้เริ่มการพัฒนาเทคโนโลยี AI ที่จะสามารถแปลภาษามือด้วยการใช้รูปแบบของท่าทางต่างๆ กว่า 30,000 รูป มาสอนให้ AI จดจำว่าแต่ละท่ามีความหมายว่าอะไรบ้าง แต่การที่จะทำให้ AI สามารถแปลได้แบบ Real-time ไม่ใช่เรื่องง่ายเลย เนื่องจากการสื่อสารด้วยภาษามือจะมีการเคลื่อนไหวที่รวดเร็วมากจนระบบ AI แปลไม่ทัน แม้ว่าจะมีกล้องหลายตัวคอยจับภาพ หรือแม้แต่เซ็นเซอร์จับความลึก 3 มิติ เข้ามาช่วยแล้วก็ตาม

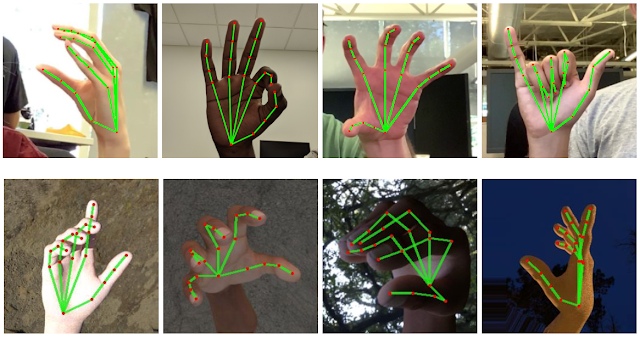

ทางนักวิจัยของ Google ก็เลยพยายามลดขนาดข้อมูลของภาษาลงเพื่อให้ได้การทำงานที่รวดเร็วขึ้น ด้วยการใช้ระบบตรวจจับฝ่ามือเข้ามาช่วย (คล้ายๆ ระบบ Face detection) เมื่อระบบสามารถหาได้ว่าฝ่ามือของคนที่เราต้องการจะแปล อยู่ตรงไหน มันก็จะกำหนดตำแหน่งต่างๆ บนมือทั้งหมด 21 จุด ซึ่งทั้งหมดนั้นจะเป็นจุดของข้อต่อนิ้วและมือที่จะเคลื่อนไหวไปในทิศทางต่างๆ และผสมผสานให้กลายเป็นภาษานั่นเอง ซึ่งวิธีนี้จะทำให้ระบบใช้พลังงานน้อยลง และยังทำให้ประมวลผลได้เร็วขึ้นจนสามารถแปลท่าทางของมือได้แทบจะทันที

แปลภาษาได้รวดเร็วแบบ Real-time

แต่ภาษามือไม่ได้จบลงแค่การใช้มือและนิ้วบิดไปในทิศทางต่างๆ เท่านั้น เพราะการสื่อสารด้วยวิธีนี้ยังต้องอาศัยการแสดงออกของใบหน้าอีกด้วย ถึงจะรู้ว่าฝ่ายตรงข้ามต้องการที่จะสื่อถึงเรื่องอะไร (ไม่งั้นอาจจะเข้าใจไปคนละทางเลยก็ได้) Google ก็เลยเปิดให้โปรเจ็คท์ดังกล่าวเป็น Open-source สำหรับนักพัฒนาต่างๆ ให้เอาเครื่องมือนี้ไปพัฒนากันต่อได้อีก

ตรวจจับได้หลายมือในครั้งเดียว

คาดว่าอาจจะต้องใช้เวลาในการพัฒนาต่ออักซักพักใหญ่ๆ กว่าที่ Google จะสามารถยัดเทคโนโลยีแปลภาษามือมาไว้ในมือถือได้ แต่เมื่อถึงเวลานั้นขึ้นมา เหล่าผู้พิการทางหูก็จะสามารถสื่อสารกับคนทั่วไปได้สะดวกขึ้น เพราะสามารถใช้ภาษามือได้เลย ไม่ต้องมาคอยพิมพ์คอยเขียนบอกฝ่ายตรงข้ามให้เสียเวลาอีกต่อไป

ที่มา : Gizchina

เจ๋งดี

เจ๋งอะ กูเกิ้ลนี่พยามพัฒนาอะไรเพื่อมนุษยชาติจริงๆ มือถือแอนดรอยด์ก็ได้อานิสงน์ไปด้วย

ส่วนอีกค่าย… ชิปเราแรงขึ้นนะ ความจุมากขึ้น กล้องดีขึ้นนะ…that's it.

ไม่เอาน้า…ไม่เหน็บสิ..อย่าไปแซวเค้าเลย…ยิ่งขาลงอยู่

อันนี้สุดยอดครับ 🙂 🙂

🙂 🙂